1. 后端

1.1 后端目录

graph LR

A["src/main/java/com/xxx/xxxSystem/"]:::root

%% 一级目录

A --> B_common["common/"]:::pkg1

A --> B_config["config/"]:::pkg2

A --> B_controller["controller/"]:::pkg3

A --> B_enums["enums/"]:::pkg4

A --> B_exception["exception/"]:::pkg5

A --> B_feignClient["feignClient/"]:::pkg6

A --> B_mapper["mapper/"]:::pkg7

A --> B_pojo["pojo/"]:::pkg8

A --> B_service["service/"]:::pkg9

A --> B_utils["utils/"]:::pkg10

%% common 下

B_common --> C_MyConstants["MyConstants.java<br/><small>常量定义</small>"]:::pkg1

%% config 下

B_config --> C_FeignConfig["FeignConfig.java<br/><small>给 Spring Cloud OpenFeign 客户端统一配置请求超时和重定向行为</small>"]:::pkg2

B_config --> C_GlobalExceptionConfig["GlobalExceptionConfig.java<br/><small>Spring Boot全局异常处理器,用于捕获所有未处理的异常,记录错误日志,并在生产环境通过RocketMQ发送异常信息到消息队列,同时返回统一格式的错误响应。</small>"]:::pkg2

B_config --> C_MybatisFlexConfig["MybatisFlexConfig.java"]:::pkg2

%% controller 下

B_controller --> C_AppInfoController["AppInfoController.java"]:::pkg3

%% enums 下

B_enums --> C_TestCaseEditStatusEnum["TestCaseEditStatusEnum.java"]:::pkg4

%% exception 下

B_exception --> C_MyException["MyException.java"]:::pkg5

%% feignClient 下

B_feignClient --> C_FileServiceCenterBackEndClient["FileServiceCenterBackEndClient.java"]:::pkg6

%% mapper 下

B_mapper --> C_AppInfoMapper["AppInfoMapper.java"]:::pkg7

%% pojo 下

B_pojo --> C_dao["dao/"]:::pkg8

B_pojo --> C_dto["dto/"]:::pkg8

B_pojo --> C_entity["entity/"]:::pkg8

B_pojo --> C_vo["vo/"]:::pkg8

B_pojo --> C_BaseResult["BaseResult.java"]:::pkg8

%% service 下

B_service --> C_impl["impl/"]:::pkg9

C_impl --> D_AppInfoServiceImpl["AppInfoServiceImpl.java"]:::pkg9

B_service --> C_AppInfoService["AppInfoService.java"]:::pkg9

%% utils 下

B_utils --> C_MyDateUtils["MyDateUtils.java"]:::pkg10

B_utils --> C_MyIpUtils["MyIpUtils.java"]:::pkg10

%% 样式定义

classDef root fill:#333,stroke:#000,color:#fff,font-size:16px;

classDef pkg1 fill:#fde2e2,stroke:#fcc, color:#900;

classDef pkg2 fill:#e0f7fa,stroke:#b2ebf2, color:#006064;

classDef pkg3 fill:#f3e5f5,stroke:#e1bee7, color:#4a148c;

classDef pkg4 fill:#fff3e0,stroke:#ffe0b2, color:#e65100;

classDef pkg5 fill:#e8f5e9,stroke:#c8e6c9, color:#1b5e20;

classDef pkg6 fill:#f1f8e9,stroke:#dcedc8, color:#33691e;

classDef pkg7 fill:#eceff1,stroke:#cfd8dc, color:#37474f;

classDef pkg8 fill:#fffde7,stroke:#fff9c4, color:#f57f17;

classDef pkg9 fill:#e8eaf6,stroke:#c5cae9, color:#283593;

classDef pkg10 fill:#fbe9e7,stroke:#ffccbc, color:#bf360c;

classDef file fill:#ffffff,stroke:#aaa, color:#333,font-size:12px;

1.1.1 POJO(Plain Ordinary Java Object):DAO、VO、DTO和实体类

简单的Java对象,实际就是普通JavaBeans

1.1.1.1 DAO(Data Access Object)

数据访问对象,DAO 是用于访问数据库的对象。它通常包含了对数据库的 CRUD(创建、读取、更新、删除)操作。DAO 与数据库直接相关,用于封装数据库操作的细节,以便其他部分的代码可以通过 DAO 来访问数据库。

在大部分生产环境中,dao对应mapper,而entity对应下方的dao

模板(以MybatisFlex为例)待补充关联查询

package com.xxx.UserBusiness.pojo.dao;

import com.fasterxml.jackson.annotation.JsonFormat;

import com.mybatisflex.annotation.Id;

import com.mybatisflex.annotation.KeyType;

import com.mybatisflex.annotation.Table;

import lombok.AllArgsConstructor;

import lombok.Data;

import lombok.NoArgsConstructor;

import lombok.experimental.Accessors;

import java.time.LocalDateTime;

@Data

@AllArgsConstructor

@NoArgsConstructor

@Accessors(chain = true)

@Table("xxxx")

public class PermissionPointMapDao {

/** 主键自增长-ID */

@Id(keyType = KeyType.Auto)

private Integer id;

/** 权限点id */

private Integer permissionPointId;

/** 权限点描述 */

private String permissionPointDescription;

/** 路由路径信息 */

private String routingPathInfo;

/** 创建时间 */

@JsonFormat(pattern = "yyyy-MM-dd HH:mm:ss", timezone = "GMT+8")

private LocalDateTime createTime;

/** 更新时间 */

@JsonFormat(pattern = "yyyy-MM-dd HH:mm:ss", timezone = "GMT+8")

private LocalDateTime updateTime;

}1.1.1.2 VO(View Object)

视图对象,VO 通常用于将从数据库中检索的数据封装为对象,然后将其传递给其他部分的代码。VO 通常与数据库中的表字段对应,用于表示数据库中的数据。

1.1.1.3 DTO(Data Transfer Object)

数据传输对象,DTO 用于在Service层和Controller层之间传输数据,特别是在前后端分离的场景中。它通常用于接收接口传入的参数,DTO的字段通常与Entity不完全相同,它根据前端的需求进行定制。(传入一两个参数可以接口处直接定义,如果是多个参数需要放在dto里)

1.1.1.4 Entity

实体类通常指的是与数据库表相对应的类。它通常包含了表的字段和与之相关的方法。实体类通常用于表示数据库中的数据,并且通常与数据库中的表字段一一对应。(公司内主要用于定义需要用的字段,和Dao是反着来的)

1.1.2 CorsConfig

1.1.3 BaseResults

package com.xxx.xxxSystem.pojo;

import com.fasterxml.jackson.annotation.JsonInclude;

import lombok.AllArgsConstructor;

import lombok.Data;

import lombok.NoArgsConstructor;

/**

* AllArgsConstructor 为当前类生成一个 全参构造器

* NoArgsConstructor 为当前类生成一个 空参构造器

* Data 为每个字段生成 getXxx() / setXxx(...)、toString()、equals() 和 hashCode() 方法

* JsonInclude(JsonInclude.Include.NON_NULL) 在将对象序列化成 JSON 时,排除所有值为 null 的字段

* */

@AllArgsConstructor

@JsonInclude(JsonInclude.Include.NON_NULL)

@Data

@NoArgsConstructor

public class BaseResult {

public static final Integer STATUS_SUCCESS = 200;

public static final Integer STATUS_FAILED = -1;

public static final String MSG_OK = "OK";

/** 响应业务状态 */

private Integer code;

/** 响应消息 */

private String msg;

/** 响应中的数据 */

private Object data;

/**

* 返回失败消息

*

* @param message 消息

* @return {@link BaseResult}

*/

public static BaseResult returnFailedWithMessage(String message) {

return new BaseResult(BaseResult.STATUS_FAILED, message, null);

}

/**

* 返回失败状态,没有消息

*

* @return {@link BaseResult}

*/

public static BaseResult returnFailedStatusWithNoMessage() {

return new BaseResult(BaseResult.STATUS_FAILED, null, null);

}

/**

* 返回成功消息 OK

*

* @return {@link BaseResult}

*/

public static BaseResult returnSuccessWithMessageOk() {

return new BaseResult(BaseResult.STATUS_SUCCESS, BaseResult.MSG_OK, null);

}

/**

* 返回成功消息和数据

*

* @param data 数据

* @return {@link BaseResult}

*/

public static BaseResult returnSuccessMessageOkAndData(Object data) {

return new BaseResult(BaseResult.STATUS_SUCCESS, BaseResult.MSG_OK, data);

}

}

BaseResults的局限

按照上述的BaseResults只能用Base64将文件放入data中传输,不适合大文件传输;或者使用构造静态资源 URL 的方式。这里介绍一些其他[传递文件的方法](#1.9.6 Java传递文件的方式),以图片为例,推荐使用字节流方式。

推荐解决方法:构造静态资源 URL

需要注意,如果后端开启了JwtToken验证,需要将URL返回给前端,前端通过axios发送token请求头,并以Blob响应形式下载文件内容。如果域名被设置了SSL加密,后端返回URL时还需要加https。

静态资源通过Blob要用GET方法下载

1.1.4 Controller

package com.xxx.xxxSystem.controller;

import com.xxx.xxxSystem.pojo.BaseResult;

import com.xxx.xxxSystem.pojo.dto.*;

import com.xxx.xxxSystem.service.AppInfoService;

import lombok.extern.slf4j.Slf4j;

import org.springframework.validation.annotation.Validated;

import org.springframework.web.bind.annotation.PostMapping;

import org.springframework.web.bind.annotation.RequestMapping;

import org.springframework.web.bind.annotation.RequestParam;

import org.springframework.web.bind.annotation.RestController;

import javax.annotation.Resource;

import javax.validation.Valid;

import javax.validation.constraints.NotEmpty;

import javax.validation.constraints.NotNull;

import java.util.List;

@RestController

@RequestMapping(value = "/xxxApi")

@Validated

@Slf4j

public class XxxController {

@Resource

private XxxService xxxService;

/**

* 创建新应用程序信息

*

* @param createNewXxxDto 创建新应用程序信息dto

* @return {@link BaseResult }

*/

@PostMapping(value = "/create/newXxx")

public BaseResult createNewXxx(@Valid CreateNewXxxDto createNewXxxDto) {

return xxxService.createNewXxx(createNewXxxDto);

}1.1.5 Service

package com.xxx.XxxSystem.service;

import com.xxx.XxxSystem.pojo.BaseResult;

import com.xxx.XxxSystem.pojo.dto.*;

import java.util.List;

public interface XxxService {

BaseResult createNewXxx(CreateNewXxxDto createNewXxxDto);

}1.1.6 ServiceImpl

package com.xxx.AutoTestCaseSystem.service.impl;

import com.mybatisflex.core.paginate.Page;

import com.mybatisflex.core.query.QueryChain;

import com.mybatisflex.core.query.QueryWrapper;

import com.mybatisflex.core.update.UpdateChain;

import com.mysql.cj.util.StringUtils;

import com.xxx.AutoTestCaseSystem.common.MyConstants;

import com.xxx.AutoTestCaseSystem.feignClient.FileServiceCenterBackEndClient;

import com.xxx.AutoTestCaseSystem.mapper.AppInfoMapper;

import com.xxx.AutoTestCaseSystem.mapper.TestCaseDetailMapper;

import com.xxx.AutoTestCaseSystem.mapper.TestMethodMapper;

import com.xxx.AutoTestCaseSystem.mapper.TestSceneMapToCaseMapper;

import com.xxx.AutoTestCaseSystem.pojo.BaseResult;

import com.xxx.AutoTestCaseSystem.pojo.dao.*;

import com.xxx.AutoTestCaseSystem.pojo.dto.*;

import com.xxx.AutoTestCaseSystem.pojo.dto.fileSystem.DeleteFileDto;

import com.xxx.AutoTestCaseSystem.pojo.entity.DifferentRoleUserList;

import com.xxx.AutoTestCaseSystem.pojo.entity.UserInfoLiteEntity;

import com.xxx.AutoTestCaseSystem.pojo.vo.AppInfoVo;

import com.xxx.AutoTestCaseSystem.service.AppInfoService;

import lombok.extern.slf4j.Slf4j;

import org.springframework.stereotype.Service;

import org.springframework.transaction.annotation.Transactional;

import javax.annotation.Resource;

import java.util.List;

import static com.xxx.AutoTestCaseSystem.enums.TestCaseEditStatusEnum.ABANDON_CHECK_PASS;

import static com.xxx.AutoTestCaseSystem.pojo.dao.table.AppInfoDaoTableDef.APP_INFO_DAO;

@Slf4j

@Service

public class AppInfoServiceImpl implements AppInfoService {

@Resource

private AppInfoMapper appInfoMapper;

@Override

@Transactional(rollbackFor = Exception.class)

public BaseResult createNewAppInfo(CreateNewAppInfoDto createNewAppInfoDto) {

List<AppInfoDao> appInfoDaoList = QueryChain.of(AppInfoDao.class)

.eq(AppInfoDao::getAppType, createNewAppInfoDto.getAppType())

.list();

boolean ifExist = appInfoDaoList.stream()

.map(AppInfoDao::getPackageName)

.anyMatch(name -> name.equals(createNewAppInfoDto.getPackageName()));

if (ifExist) {

String errMsg = "createNewAppInfo: " + "xxx已存在,请检查后重试";

log.error(errMsg);

return BaseResult.returnFailedWithMessage(errMsg);

}

AppInfoDao appInfoDao = new AppInfoDao();

appInfoDao

.setAppName(createNewAppInfoDto.getAppName())

.setPackageName(createNewAppInfoDto.getPackageName());

appInfoMapper.insertSelective(appInfoDao);

return BaseResult.returnSuccessWithMessageOk();

}1.2 SQL配置与使用

1.2.1 连接

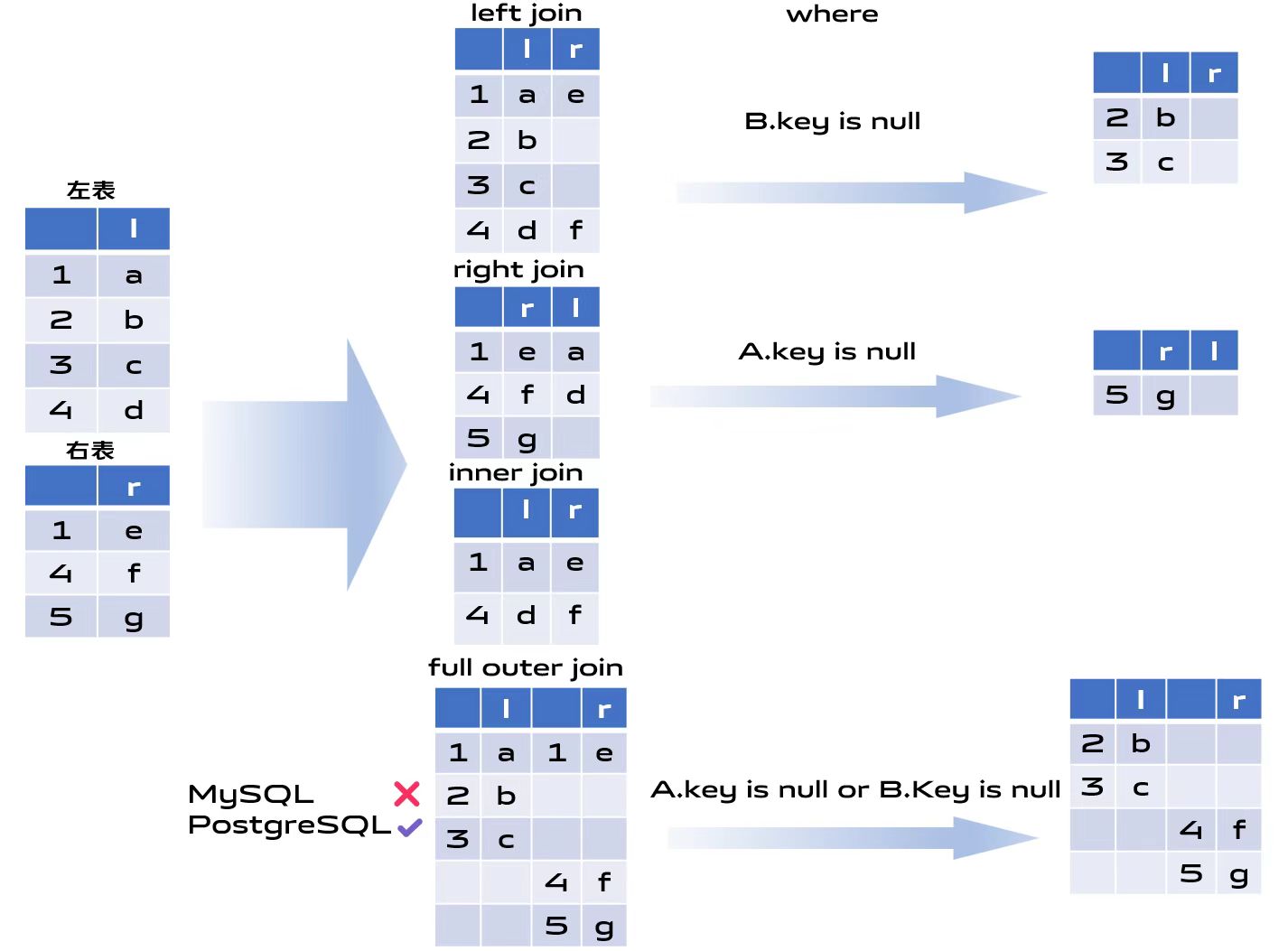

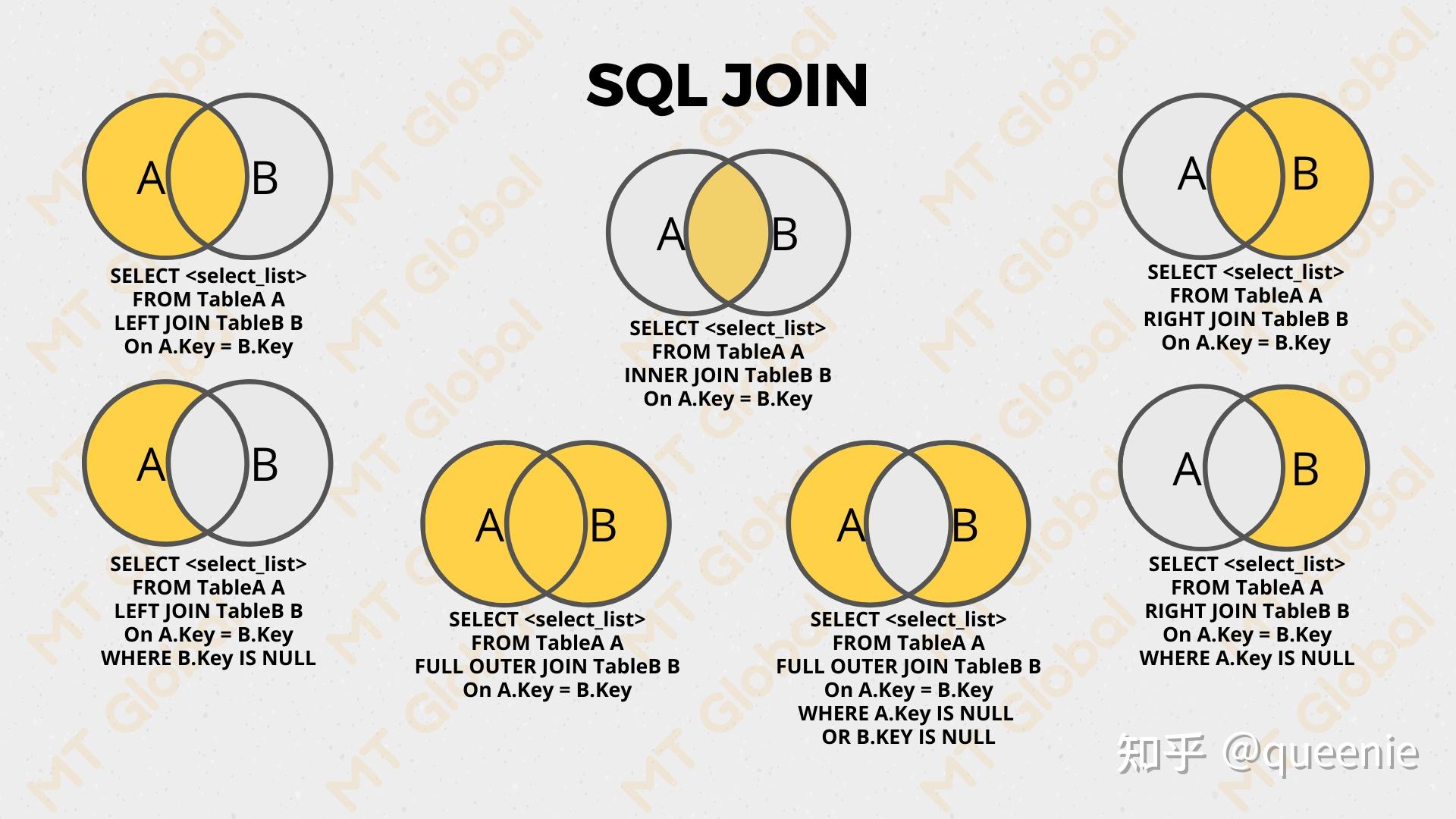

- 内连接(JOIN / INNER JOIN)

- 只保留两张表都能匹配上的行。

- MyBatis‑Flex:

.innerJoin(OtherDao.class).on(...)或者只写join

- 左外连接(LEFT OUTER JOIN / LEFT JOIN)

- 保留左表的所有行,右表匹配不到的列填

NULL。 - MyBatis‑Flex:

.leftJoin(OtherDao.class).on(...)

- 保留左表的所有行,右表匹配不到的列填

- 右外连接(RIGHT OUTER JOIN / RIGHT JOIN)

- 保留右表的所有行,左表匹配不到的列填

NULL。 - MyBatis‑Flex:

.rightJoin(OtherDao.class).on(...)

- 保留右表的所有行,左表匹配不到的列填

- 全外连接(FULL OUTER JOIN / FULL JOIN)

- 左右两表的所有行都保留,匹配不到的列填

NULL。 - MySql原生不支持这种写法,PostgreSql支持

- MyBatis‑Flex:

.fullJoin(OtherDao.class).on(...)

- 左右两表的所有行都保留,匹配不到的列填

其他加where的如下图所示都是上面连接的变种,即加过滤条件

https://zhuanlan.zhihu.com/p/30757775036

交叉连接(CROSS JOIN)

- 含义:将左表和右表中的每一行两两配对,返回笛卡尔积。

- 结果行数 = 左表行数 × 右表行数。

- MyBatis‑Flex:

.crossJoin(OtherDao.class).on(...)

自然连接(NATURAL JOIN)

- 含义:根据同名列按照内连接自动匹配。

- 使用方法:只能在sql语句里写,MybatisFlex不支持

SELECT *

FROM tableA

NATURAL JOIN tableB;- 自连接(Self‑Join)

- 含义:将一张表“复制”成两个逻辑实体表(通过不同别名),然后在它们之间做连接。

- 使用方法:只能用其他join实现相同的效果

SELECT e.id AS emp_id,

e.name AS emp_name,

m.id AS mgr_id,

m.name AS mgr_name

FROM employee AS e

LEFT JOIN employee AS m

ON e.manager_id = m.id;- Union

- 含义:集合操作符,用于把两个或多个

SELECT语句的结果“垂直”合并成一个结果集。 - 使用方法:

- 含义:集合操作符,用于把两个或多个

SELECT 列列表

FROM 表1

WHERE 条件1

UNION

SELECT 列列表

FROM 表2

WHERE 条件2;- 结果:

| id | val |

|---|---|

| 1 | e |

| 1 | a |

| 2 | b |

| 3 | c |

| 4 | f |

| 4 | d |

| 5 | g |

1.2.2 数据库连接池

配置

spring:

...

datasource:

url: jdbc:mysql://IP:3306/xxl_job?useSSL=false&characterEncoding=UTF-8&allowPublicKeyRetrieval=true&allowMultiQueries=true&serverTimezone=Asia/Shanghai

username: xxx

password: xxx

driver-class-name: com.mysql.cj.jdbc.Driver

type: com.zaxxer.hikari.HikariDataSource

hikari:

# 连接池的最小连接数,低于这个数会补充

minimum-idle: 10

# 连接池的最大连接数

maximum-pool-size: 30

# 默认自动提交事务

auto-commit: true

# 空闲连接 30s 没用会被回收

idle-timeout: 30000

# 线程池名字(方便日志里区分)

pool-name: HikariCP

# 连接最长存活时间(15分钟)

max-lifetime: 900000

# 获取连接的最大等待时间(10秒)

connection-timeout: 10000

# 用来检测连接是否可用

connection-test-query: SELECT 1

# 校验连接的超时时间

validation-timeout: 1000com.zaxxer.hikari.HikariDataSource 是什么?

它是 HikariCP 的数据源类。

- HikariCP 是目前 Spring Boot 默认使用的数据库连接池实现(性能非常好)。

HikariDataSource就是它的核心类,Spring Boot 会用它来管理数据库连接,它是 Spring Boot 默认推荐的连接池(比 Druid、C3P0、Tomcat JDBC 都快)。

连接池的作用

数据库连接很“贵”,频繁开关连接会很慢,连接池可以提高性能。

- 预先创建一批连接(比如 10 个)

- 程序要用时,直接从池里取,不用再跟数据库“重新握手”

- 用完再放回池子,下一个线程可以复用

Alibaba Druid

1.2.3 性能优化

SQLsession

索引

是否唯一?

1.2.4 SQL注入

在代码编写过程中,直接暴露SQL语句的地方,不能直接传递变量。

- 风险来自:

"DISTINCT " + columnName这种把SQL 结构(列名/关键字)用字符串拼出来 - 不是所有拼接都危险:拼接值如果走

#{}参数化就安全,但列名永远没法参数化,只能拼:

qw.select("DISTINCT " + columnName)只要 columnName 是外部输入,就必须做你上面那种白名单校验,否则就可能:

- 传不存在列 → 直接 500

- 传恶意片段 → 注入(是否能成功取决于驱动/数据库是否允许多语句等,但不能赌)

用通用方法 + 条件值参数(安全)

比如 MyBatis-Plus 这种:

LambdaQueryWrapper<UsersInfoEntity> qw = Wrappers.lambdaQuery();

qw.eq(UsersInfoEntity::getAsset, assetValue);

usersInfoMapper.selectList(qw);这里的 assetValue 会走参数化(本质 #{}),属于值参数,一般不产生注入问题。

1.3 Mybatis

1.3.1 SqlSession

SqlSession 这个概念来自 MyBatis(MyBatis-Flex、MyBatis-Plus 也是在它之上扩展的)。它的作用,可以简单理解为:

SqlSession就是 和数据库交互的会话对象,你通过它来执行 SQL语句(增删改查)。- 类似于 JDBC 里的

Connection + Statement的结合体。 - 它不是线程安全的,每次使用都应该获取一个新的,使用完要关闭。

1.3.1.1 主要功能

selectOne/selectList:查询insert:插入update:更新delete:删除getMapper(Class<T> type):获取一个 Mapper 接口的代理(推荐用这个方式调用,而不是直接写 SQL ID)

在 SpringBoot 集成 MyBatis 后,一般不用你手动管理 SqlSession 了:

- Spring 会把

SqlSession封装成SqlSessionTemplate(线程安全的),交给 IOC 容器管理。 - 你只需要注入

Mapper接口就能用。

1.3.1.2 实战

我们可以利用SqlSession的功能进行一些批量操作。

例如,我们可以先将逐条生成 SQL,但不立刻发给数据库;而是先放到 JDBC 驱动的 batch 缓冲区。在循环500次后批量commit。结束要手动关闭

@Override

@Transactional(rollbackFor = Exception.class)

public BaseResult deleteCaseInfoByCasIdList(List<Integer> caseIdList) {

SqlSession sqlSession = sqlSessionFactory.openSession(ExecutorType.BATCH, false);

CaseCollectionDetailMapper batchMapper = sqlSession.getMapper(CaseCollectionDetailMapper.class);

try {

for (int i = 0; i < caseIdList.size(); i++) {

int caseIdIndex = caseIdList.get(i);

LambdaQueryWrapper<CaseCollectionDetailDao> lambdaQueryWrapper = new LambdaQueryWrapper<>();

lambdaQueryWrapper.eq(CaseCollectionDetailDao::getCaseId, caseIdIndex);

// 1 查询原案例信息,删除原文件信息

CaseCollectionDetailDao caseCollectionDetailDao = batchMapper.selectOne(lambdaQueryWrapper);

if (caseCollectionDetailDao == null) {

throw new MyException(MyConstants.MSG_DATA_SEARCH_RESULT_NULL);

}

DeleteFileDto deleteFileDto = new DeleteFileDto();

deleteFileDto.setBusinessPlatform(MyConstants.STRING_BUSINESS_PLATFORM_CASE_COLLECTION);

List<String> oldFileTidOfBeforeModifyTidList = new ArrayList<>();

oldFileTidOfBeforeModifyTidList.add(caseCollectionDetailDao.getFileTidBeforeModify());

// 2 调用接口删除对应的文件

deleteFileDto.setBusinessTidList(oldFileTidOfBeforeModifyTidList);

BaseResult fileBeforeModifyDeleteResult = fileServiceCenterBackEndClient.deleteBatchFilesByTidList(deleteFileDto);

if (BaseResult.STATUS_FAILED.equals(fileBeforeModifyDeleteResult.getStatus())) {

throw new MyException("fileBeforeModify delete failed, msg = " + fileBeforeModifyDeleteResult.getMsg());

}

List<String> oldFileTidOfAfterModifyTidList = new ArrayList<>();

oldFileTidOfAfterModifyTidList.add(caseCollectionDetailDao.getFileTidAfterModify());

deleteFileDto.setBusinessTidList(oldFileTidOfAfterModifyTidList);

BaseResult fileAfterModifyDeleteResult = fileServiceCenterBackEndClient.deleteBatchFilesByTidList(deleteFileDto);

if (BaseResult.STATUS_FAILED.equals(fileAfterModifyDeleteResult.getStatus())) {

throw new MyException("fileAfterModify delete failed, msg = " + fileAfterModifyDeleteResult.getMsg());

}

// 3 删除数据

batchMapper.delete(lambdaQueryWrapper);

if (i % 500 == 499) {

//每500条提交一次防止内存溢出

sqlSession.commit();

sqlSession.clearCache();

}

}

} catch (Exception e) {

log.error("deleteCaseInfoByCasIdList -- operate batch error, e = ", e);

sqlSession.rollback();

sqlSession.close();

return BaseResult.returnFailedWithMessage(MyConstants.MSG_DATA_DELETE_BATCH_FAILS);

} finally {

sqlSession.commit();

sqlSession.clearCache();

sqlSession.close();

}

return BaseResult.returnSuccessWithMessageOk();

}1.3.2 MybatisFlex

Config

package com.xxx.AutoTestCaseSystem.config;

import com.mybatisflex.core.FlexGlobalConfig;

import com.mybatisflex.core.mybatis.FlexConfiguration;

import com.mybatisflex.spring.boot.ConfigurationCustomizer;

import com.mybatisflex.spring.boot.MyBatisFlexCustomizer;

import org.mybatis.spring.annotation.MapperScan;

import org.springframework.context.annotation.Configuration;

@Configuration

@MapperScan("com.xxx.AutoTestCaseSystem.mapper")

public class MybatisFlexConfig implements ConfigurationCustomizer, MyBatisFlexCustomizer {

@Override

public void customize(FlexConfiguration flexConfiguration) {

// 开启驼峰映射 原始配置中,默认配置开关状态:true

flexConfiguration.setMapUnderscoreToCamelCase(true);

// 开启log日志

// flexConfiguration.setLogImpl(StdOutImpl.class);

}

@Override

public void customize(FlexGlobalConfig flexGlobalConfig) {

}

}Join

MybatisFlex具有和MybatisPlusJoin(MybatisPlus的社区扩展)类似的能力,支持join。在不写select且不指定查询哪张表的情况下默认查询所有

关联查询

@RelationOneToOne(selfField = "commitId", targetField = "userUuid", targetTable = "user_info", valueField = "deptCode")

private String deptCode;相当于左连接,根据当前表的commitId == user_1_basic_info表的userUuid进行连接,查询deptCode,表面是要查提交人的部门代码。需要在前面写好.withRelations()或者.paginateWithRelationsAs。

逻辑删

MybatisFlex也有逻辑删功能,用法与plus略有不同

@Data

@AllArgsConstructor

@NoArgsConstructor

@Accessors(chain = true)

@Table("table_name")

public class VideoProblemDetailDao {

/** id - 主键自增长 */

@Id(keyType = KeyType.Auto)

private Integer id;

/** 默认0, 逻辑删除状态(归档用):1-已删除;0-未删除 */

@Column(isLogicDelete = true)

private Integer isDeleted;

}查询时,默认查未逻辑删的内容,如果需要全查需要区分。

List<Dao> DaoList = LogicDeleteManager.execWithoutLogicDelete(() ->

QueryChain.of(Dao.class).list()

);UpdateChain

QueryChain不能用于Dao更改,需要用UpdateChain处理,或者用Mapper调用自定义或者update等通用方法。

乐观锁

类似Plus,Flex也有乐观锁开启的方法:

@Column(version = true)

private Integer dataVersion;update数据时,如果有两个线程同时更新,当有一个线程已经将版本+1,另一个线程就不能再更新了。

| 时间 | 线程A | 线程B |

|---|---|---|

| T1 | 读到 data_version=5 | 读到 data_version=5 |

| T2 | 改字段并提交 → 版本从 5 变 6 | |

| T3 | 改字段并提交 → WHERE 条件要求 data_version=5,但现在是6 → 更新失败 |

如果需要在乐观锁冲突时回滚,需要自己抛异常

实战

package com.vivo.AnimationOpinionControlSystem.service.impl;

import com.mybatisflex.core.paginate.Page;

import com.mybatisflex.core.query.QueryChain;

import com.vivo.AnimationOpinionControlSystem.pojo.BaseResult;

import com.vivo.AnimationOpinionControlSystem.pojo.dao.OpinionClassifiedResultDao;

import com.vivo.AnimationOpinionControlSystem.pojo.dao.OpinionDetailDao;

import com.vivo.AnimationOpinionControlSystem.pojo.dao.OpinionThresholdInfoDao;

import com.vivo.AnimationOpinionControlSystem.pojo.dto.OpionionPreWarning.QueryPreWarningInfoDto;

import com.vivo.AnimationOpinionControlSystem.pojo.vo.OpinionPreWarningVo;

import com.vivo.AnimationOpinionControlSystem.service.OpinionPreWarningService;

import com.vivo.AnimationOpinionControlSystem.utils.MyDateUtils;

import com.vivo.AnimationOpinionControlSystem.utils.OpinionDataUtils;

import lombok.extern.slf4j.Slf4j;

import org.springframework.stereotype.Service;

import javax.annotation.Resource;

import java.util.Arrays;

import java.util.Collections;

import java.util.Date;

import java.util.List;

import static com.mybatisflex.core.query.QueryMethods.count;

@Slf4j

@Service

public class OpinionPreWarningServiceImpl implements OpinionPreWarningService {

@Resource

private OpinionDataUtils opinionDataUtils;

@Override

public BaseResult queryImportantOpinionByMultiConditions(QueryPreWarningInfoDto queryPreWarningInfoDto) {

Date feedbackStartDate = MyDateUtils.timestampStringToDate(queryPreWarningInfoDto.getFeedbackStartDate());

Date feedbackEndDate = MyDateUtils.timestampStringToDate(queryPreWarningInfoDto.getFeedbackEndDate());

if (feedbackStartDate == null || feedbackEndDate == null) {

String errorMsg = "查询时间解析结果为null。" + "queryPreWarningInfoDto = " + queryPreWarningInfoDto;

log.error(errorMsg);

return BaseResult.returnFailedWithMessage(errorMsg);

}

boolean queryAllList = queryPreWarningInfoDto.getWhetherQueryAllList() != null && queryPreWarningInfoDto.getWhetherQueryAllList() == 1;

List<Integer> opinionIdList = opinionDataUtils.getOpinionIdListByFeedbackDateRange(feedbackStartDate, feedbackEndDate);

if (opinionIdList == null || opinionIdList.isEmpty()) {

if (queryAllList) {

return BaseResult.returnSuccessMessageOkAndData(Collections.<OpinionPreWarningVo>emptyList());

} else {

return BaseResult.returnSuccessMessageOkAndData(new Page<OpinionPreWarningVo>(queryPreWarningInfoDto.getPageIndex(), queryPreWarningInfoDto.getPageSize()));

}

}

int opinionPreWarningType = queryPreWarningInfoDto.getOpinionPreWarningType();

int opinionThresholdType;

switch (opinionPreWarningType) {

case 1:

opinionThresholdType = 2;

break;

case 2:

opinionThresholdType = 1;

break;

case 3:

opinionThresholdType = 3;

break;

default:

opinionThresholdType = opinionPreWarningType;

}

Integer opinionThreshold = QueryChain.of(OpinionThresholdInfoDao.class)

.select(OpinionThresholdInfoDao::getThresholdValue)

.eq(OpinionThresholdInfoDao::getId, opinionThresholdType)

.oneAs(Integer.class);

if (opinionPreWarningType == 3 && opinionThreshold != null) {

Date currentDate = feedbackStartDate;

boolean thresholdExceeded = true;

while (!currentDate.after(feedbackEndDate)) {

Long dayCount = QueryChain.of(OpinionClassifiedResultDao.class)

.in(OpinionClassifiedResultDao::getOpinionId, opinionIdList)

.leftJoin(OpinionDetailDao.class)

.on(OpinionDetailDao::getOpinionId, OpinionClassifiedResultDao::getOpinionId)

.eq(OpinionDetailDao::getFeedbackDate, currentDate)

.count();

if (dayCount < opinionThreshold) {

thresholdExceeded = false;

break;

}

currentDate = new Date(currentDate.getTime() + 24 * 60 * 60 * 1000);

}

if (!thresholdExceeded) {

if (queryAllList) {

return BaseResult.returnSuccessMessageOkAndData(Collections.<OpinionPreWarningVo>emptyList());

} else {

return BaseResult.returnSuccessMessageOkAndData(

new Page<OpinionPreWarningVo>(queryPreWarningInfoDto.getPageIndex(), queryPreWarningInfoDto.getPageSize())

);

}

}

}

QueryChain<OpinionClassifiedResultDao> opinionClassifiedResultGroupQueryChain = QueryChain.of(OpinionClassifiedResultDao.class)

.in(OpinionClassifiedResultDao::getOpinionId, opinionIdList)

.select(OpinionClassifiedResultDao::getOsVersion)

.select(OpinionClassifiedResultDao::getMainCategoryId)

.select(OpinionClassifiedResultDao::getLevelOneCategoryPk)

.select(OpinionClassifiedResultDao::getLevelTwoCategoryPk)

.select(OpinionClassifiedResultDao::getClassifiedResultId)

.select(count().as("opinionCount"))

.in(OpinionClassifiedResultDao::getOpinionType, Arrays.asList(1, 4))

.groupBy(OpinionClassifiedResultDao::getMainCategoryId)

.groupBy(OpinionClassifiedResultDao::getLevelOneCategoryPk)

.groupBy(OpinionClassifiedResultDao::getLevelTwoCategoryPk)

.groupBy(OpinionClassifiedResultDao::getOsVersion)

.having(count().ge(opinionThreshold));

if (queryPreWarningInfoDto.getOpinionPreWarningType() == 1) {

// 单日重点舆情考虑VIP和大v反馈

opinionClassifiedResultGroupQueryChain.leftJoin(OpinionDetailDao.class)

.on(OpinionDetailDao::getOpinionId, OpinionClassifiedResultDao::getOpinionId)

.in(OpinionDetailDao::getFeedbackChannel, Arrays.asList(2, 7))

.select(OpinionDetailDao::getFeedbackChannel)

.groupBy(OpinionDetailDao::getFeedbackChannel);

}

if (queryAllList) {

List<OpinionPreWarningVo> opinionPreWarningVoList = opinionClassifiedResultGroupQueryChain

.withRelations()

.listAs(OpinionPreWarningVo.class);

for (OpinionPreWarningVo opinionPreWarningVo : opinionPreWarningVoList) {

opinionPreWarningVo.setOpinionThreshold(opinionThreshold);

List<String> originalOpinionLinkList = QueryChain.of(OpinionClassifiedResultDao.class)

.eq(OpinionClassifiedResultDao::getClassifiedResultId, opinionPreWarningVo.getClassifiedResultId())

.select(OpinionDetailDao::getOriginalOpinionLink)

.leftJoin(OpinionDetailDao.class)

.on(OpinionDetailDao::getOpinionId, OpinionClassifiedResultDao::getOpinionId)

.listAs(String.class);

opinionPreWarningVo.setOriginalOpinionLinkList(originalOpinionLinkList);

List<Integer> ids = QueryChain.of(OpinionClassifiedResultDao.class)

.eq(OpinionClassifiedResultDao::getClassifiedResultId, opinionPreWarningVo.getClassifiedResultId())

.select(OpinionClassifiedResultDao::getOpinionId)

.listAs(Integer.class);

opinionPreWarningVo.setOpinionIdList(ids);

}

return BaseResult.returnSuccessMessageOkAndData(opinionPreWarningVoList);

} else {

Page<OpinionPreWarningVo> opinionPreWarningVoPage = opinionClassifiedResultGroupQueryChain

.withRelations()

.pageAs(new Page<>(queryPreWarningInfoDto.getPageIndex(), queryPreWarningInfoDto.getPageSize()), OpinionPreWarningVo.class);

for (OpinionPreWarningVo opinionPreWarningVo : opinionPreWarningVoPage.getRecords()) {

opinionPreWarningVo.setOpinionThreshold(opinionThreshold);

List<String> originalOpinionLinkList = QueryChain.of(OpinionClassifiedResultDao.class)

.eq(OpinionClassifiedResultDao::getClassifiedResultId, opinionPreWarningVo.getClassifiedResultId())

.select(OpinionDetailDao::getOriginalOpinionLink)

.leftJoin(OpinionDetailDao.class)

.on(OpinionDetailDao::getOpinionId, OpinionClassifiedResultDao::getOpinionId)

.listAs(String.class);

opinionPreWarningVo.setOriginalOpinionLinkList(originalOpinionLinkList);

List<Integer> ids = QueryChain.of(OpinionClassifiedResultDao.class)

.eq(OpinionClassifiedResultDao::getClassifiedResultId, opinionPreWarningVo.getClassifiedResultId())

.select(OpinionClassifiedResultDao::getOpinionId)

.listAs(Integer.class);

opinionPreWarningVo.setOpinionIdList(ids);

}

return BaseResult.returnSuccessMessageOkAndData(opinionPreWarningVoPage);

}

}

}附其他文件:

Dao

package com.vivo.AnimationOpinionControlSystem.pojo.dao;

import com.fasterxml.jackson.annotation.JsonFormat;

import com.mybatisflex.annotation.Column;

import com.mybatisflex.annotation.Id;

import com.mybatisflex.annotation.KeyType;

import com.mybatisflex.annotation.Table;

import lombok.AllArgsConstructor;

import lombok.Data;

import lombok.NoArgsConstructor;

import lombok.experimental.Accessors;

import java.time.LocalDateTime;

@Data

@AllArgsConstructor

@NoArgsConstructor

@Accessors(chain = true)

@Table("animation_opinion_5_classified_result")

public class OpinionClassifiedResultDao {

/** 主键自增长,分类结果Pk */

@Id(keyType = KeyType.Auto)

private Integer classifiedResultPk;

/** 主键自增长,分类结果ID */

private String classifiedResultId;

/** 舆情ID */

private Integer opinionId;

/** 默认-1,舆情类型,1-bug类,2-需求类 */

private Integer opinionType;

/** 默认-1,情感类型,1-负向,2-中性,3-正向,4-负向(未明确场景) */

private Integer emotionType;

/** os版本信息 */

private String osVersion;

/** 主分类ID */

private Integer mainCategoryId;

/** 一级分类ID 主键 */

private Integer levelOneCategoryPk;

/** 二级分类ID 主键 */

private Integer levelTwoCategoryPk;

/** 分类备注 */

private String classifiedRemark;

/** 默认1,审核状态,1-初筛,2-复审,3-公开,4-已废弃 */

private Integer reviewStatus;

/** 分类结果创建人工号 */

private String classifiedResultCreatorId;

/** 分类结果更新人工号 */

private String classifiedResultUpdaterId;

/** 默认0, 数据版本,更新数据,自动+1 */

@Column(version = true)

private Integer dataVersion;

/** 创建时间 */

@JsonFormat(pattern = "yyyy-MM-dd HH:mm:ss", timezone = "GMT+8")

private LocalDateTime createTime;

/** 更新时间 */

@JsonFormat(pattern = "yyyy-MM-dd HH:mm:ss", timezone = "GMT+8")

private LocalDateTime updateTime;

}Vo

package com.vivo.AnimationOpinionControlSystem.pojo.vo;

import com.mybatisflex.annotation.RelationOneToOne;

import lombok.AllArgsConstructor;

import lombok.Data;

import lombok.NoArgsConstructor;

import lombok.experimental.Accessors;

import java.util.List;

@Data

@AllArgsConstructor

@NoArgsConstructor

@Accessors(chain = true)

public class OpinionPreWarningVo {

/** os版本信息 */

private String osVersion;

/** 主分类ID */

private Integer mainCategoryId;

/** 一级分类ID 主键 */

private Integer levelOneCategoryPk;

/** 二级分类ID 主键 */

private Integer levelTwoCategoryPk;

/** 分类结果ID */

private String classifiedResultId;

/** 舆情数量 */

private Long opinionCount;

/** 反馈渠道 */

private Integer feedbackChannel;

/** 预警阈值 */

private Integer opinionThreshold;

/** 舆情原声列表 */

private List<String> originalOpinionLinkList;

/** 舆情ID列表 */

private List<Integer> opinionIdList;

/** 舆情问题ID,格式为AOP241119001,即动效舆情问题缩写AOP+年月日+三位数问题序号 */

@RelationOneToOne(selfField = "classifiedResultId", targetField = "classifiedResultId", targetTable = "animation_opinion_6_problem_binding_detail", valueField = "opinionProblemId")

private String opinionProblemId;

// OpinionMainCategoryDao 属性

/** 主分类描述 */

@RelationOneToOne(selfField = "mainCategoryId", targetField = "mainCategoryId", targetTable = "animation_opinion_2_main_category", valueField = "mainCategoryDescription")

private String mainCategoryDescription;

// OpinionLevelOneCategoryDao 属性

/** 一级分类描述 */

@RelationOneToOne(selfField = "levelOneCategoryPk", targetField = "levelOneCategoryPk", targetTable = "animation_opinion_3_level_one_category", valueField = "levelOneCategoryDescription")

private String levelOneCategoryDescription;

/** 一级分类ID */

@RelationOneToOne(selfField = "levelOneCategoryPk", targetField = "levelOneCategoryPk", targetTable = "animation_opinion_3_level_one_category", valueField = "levelOneCategoryId")

private Integer levelOneCategoryId;

// OpinionLevelTwoCategoryVo 属性

/** 二级分类描述 */

@RelationOneToOne(selfField = "levelTwoCategoryPk", targetField = "levelTwoCategoryPk", targetTable = "animation_opinion_4_level_two_category", valueField = "levelTwoCategoryDescription")

private String levelTwoCategoryDescription;

/** 二级分类ID */

@RelationOneToOne(selfField = "levelTwoCategoryPk", targetField = "levelTwoCategoryPk", targetTable = "animation_opinion_4_level_two_category", valueField = "levelTwoCategoryId")

private Integer levelTwoCategoryId;

}

Dto

package com.vivo.AnimationOpinionControlSystem.pojo.dto.OpionionPreWarning;

import lombok.AllArgsConstructor;

import lombok.Data;

import lombok.NoArgsConstructor;

import lombok.experimental.Accessors;

import javax.validation.constraints.NotBlank;

import javax.validation.constraints.NotNull;

@Data

@AllArgsConstructor

@NoArgsConstructor

@Accessors(chain = true)

public class QueryPreWarningInfoDto {

/** 舆情预警类型 */

@NotNull(message = "opinionPreWarningType 不能为null")

private Integer opinionPreWarningType;

/** 反馈开始日期 */

@NotNull(message = "feedbackStartDate 不能为null")

@NotBlank(message = "feedbackStartDate 不能为空字符串")

private String feedbackStartDate;

/** 反馈结束日期 */

@NotNull(message = "feedbackEndDate 不能为null")

@NotBlank(message = "feedbackEndDate 不能为空字符串")

private String feedbackEndDate;

/** 是否查询所有list,1-是,其他情况,否 */

private Integer whetherQueryAllList;

/** 页面索引 */

@NotNull(message = "页面索引 不能为null")

private Integer pageIndex;

/** 页面大小 */

@NotNull(message = "页面大小 不能为null")

private Integer pageSize;

}1.3.3 MybatisPlus

1.4 中间件-消息队列

1.4.1 RocketMQ

1.4.1.1 配置方法

# RocketMQ 配置

rocketmq:

# RocketMQ 地址

name-server: IP:9876

producer:

# 当前生产者(服务)所属的生产者组

group: begs-producer-dev上述配置表示为当前生产者配置一个[生产者组](#1.4.1.4 生产者组(Producer Group))名。

1.4.1.2 监听方法 / 消息消费

@RocketMQMessageListener(topic = "topic-bugUpdateTask", consumerGroup = "consumerGroup-bugUpdateTask", consumeMode = ConsumeMode.ORDERLY)消息的发送是基于 Topic

消费模式

顺序消费(Orderly):

- 消息将按照生产者发送消息的顺序逐一处理。

- 同一消息队列中的消息被 顺序消费,即消息消费的顺序与生产消息的顺序相同。

- 如果消费一个队列的消息时出现问题,RocketMQ 会继续从该队列中消费下一条消息,而不会跳到其他队列。即使消费失败,它会尝试重试当前队列中的消息。

- RocketMQ 会为每个 消息队列 分配一个 消费线程,并确保该线程按照消息的顺序进行消费。

- 如果有多个队列,消息会被分发到不同的消费线程上处理,但每个线程内部的消费是有序的。

- 适合需要确保消息顺序的场景,例如事务处理、订单系统、支付系统等。

并行消费(Concurrently):

- 在并行消费模式下,RocketMQ 会按并行消费的方式将同一个队列中的消息分配给多个消费线程,或者从多个消息队列中并行消费消息,即不保证顺序。

- 不保证同一个消息队列中的消息按顺序消费。

- 该模式适用于对消息顺序没有严格要求的场景,能够提高消息的处理吞吐量。

- 但如果消费队列中的消息有严格的顺序要求,可能会出现问题。

1.4.1.3 消息生产 / 发送

rocketMqTemplate.convertAndSend("topic-catchGlobalException", collectGlobalExceptionEventDto);1.4.1.4 生产者组(Producer Group)

介绍

当启动多个生产者实例时,它们会被归为同一个组,使用这个组名向 RocketMQ 发送消息。

在 RocketMQ 中,生产者组 是 逻辑上的分组。生产者实例(服务)在发送消息时,只需声明属于哪个生产者组,而不需要显式地向生产者组注册自己的 IP 地址或端口。

作用

消息发送统计与管理:RocketMQ 使用生产者组来统计和管理消息的发送状态、发送频率、负载均衡以及进行流控等。虽然消息的发送是基于

Topic,但 RocketMQ 会根据生产者组进行资源调度。故障恢复与重试:在分布式系统中,如果一个生产者实例失败了,另一个生产者实例仍然可以继续通过同一个生产者组进行消息发送。

配置共用:所有的生产者共用一个生产者组配置。这个可以在配置文件里写,也可以写java代码

1.4.1.5 消费者组(Consumer Group)

介绍

消费者组也是逻辑分组,其作用是管理多个消费者实例,并确保消息在消费者组内的 负载均衡消费。

作用

- 消息消费分配与负载均衡:消费者组帮助 RocketMQ 将消息 均匀地分配 给组内的各个消费者实例。

- 消息消费的可靠性:消费者组使得消息消费的可靠性得到保障。如果某个消费者实例失败,会分配给同一个消费者组中的其他消费者实例,确保没有消息丢失。

Topic和Group结合:消费者组监听Topic,并从该Topic中获取并消费消息。如果没有配置消费者组,RocketMQ 会认为所有的消费者都属于一个默认的消费者组,这样每个消息将被所有消费者实例同时消费。- 配置共用

1.4.1.6 消息路由

消息路由是指消息从生产者发送到 RocketMQ 中的 消息队列的过程。它决定了每条消息会被路由到哪个消息队列。

消息队列的选择:每个

topic下有多个queue(使用 MQAdminExt 手动配置)。生产者通过消息路由算法选择将消息发送到哪个消息队列。负载均衡策略:对于多个生产者实例,RocketMQ 会使用一定的策略(如轮询、哈希等)来分配消息队列。生产者会通过这些策略将消息发送到不同的队列,以实现负载均衡。

常见的消息路由方式:

- 轮询方式(Round-robin):如果生产者组中有多个生产者实例,它们会轮流选择消息队列进行消息的发送。每个生产者轮流选择消息队列,确保负载均衡。

- 哈希方式(Hashing):在某些场景下,RocketMQ 会使用哈希算法来将消息发送到特定的队列。通常是通过消息的内容(如

messageKey或messageId)来决定消息路由到哪个队列。例如,同一个messageKey的消息可能会总是被路由到同一个队列,以保证消息的顺序性。 - 广播方式(Broadcast):对于广播消息模式,RocketMQ 会将消息广播到所有的队列,不进行负载均衡。所有的消费者都能够接收到相同的消息。

RabbitMQ

Kafka

1.5 中间件-Redis

Redis 是一个开源的、基于内存的、可可选持久化的 键值对存储数据库。它通常被用作 缓存、数据库、消息代理和实时数据处理引擎。

Config

Spring:

# redis配置

redis:

host: 172.16.101.171

port: 6379

# redis访问密码

password: jzjxRedis

# 连接超时时间 单位毫秒 10秒

timeout: 10000

# 默认数据库 - 第1个数据库,一共有16个DB

database:

db0: 0

db1: 1

db2: 2

jedis:

pool:

# 连接池最大连接数(使用负值表示没有限制) 默认为 8

max-active: 1000

# 连接池最大阻塞等待时间(使用负值表示没有限制) 默认为 -1 ,单位ms

max-wait: -1

# 连接池中的最大空闲连接 默认为 8

max-idle: 10

# 连接池中的最小空闲连接 默认为 0

min-idle: 5package com.vivo.PlatformBuriedPointSystem.config;

import com.fasterxml.jackson.annotation.JsonAutoDetect;

import com.fasterxml.jackson.annotation.JsonTypeInfo;

import com.fasterxml.jackson.annotation.PropertyAccessor;

import com.fasterxml.jackson.databind.ObjectMapper;

import com.fasterxml.jackson.databind.jsontype.impl.LaissezFaireSubTypeValidator;

import lombok.extern.slf4j.Slf4j;

import org.apache.commons.pool2.impl.GenericObjectPoolConfig;

import org.springframework.beans.factory.annotation.Value;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

import org.springframework.context.annotation.Primary;

import org.springframework.data.redis.connection.RedisConfiguration;

import org.springframework.data.redis.connection.RedisStandaloneConfiguration;

import org.springframework.data.redis.connection.lettuce.LettuceConnectionFactory;

import org.springframework.data.redis.connection.lettuce.LettucePoolingClientConfiguration;

import org.springframework.data.redis.core.RedisTemplate;

import org.springframework.data.redis.serializer.Jackson2JsonRedisSerializer;

import org.springframework.data.redis.serializer.StringRedisSerializer;

import java.time.Duration;

@Configuration

@Slf4j

public class RedisConfig {

@Value("${spring.redis.database.db0}")

private int db0;

@Value("${spring.redis.database.db1}")

private int db1;

@Value("${spring.redis.database.db2}")

private int db2;

@Value("${spring.redis.host}")

private String host;

@Value("${spring.redis.password}")

private String password;

@Value("${spring.redis.port}")

private int port;

@Value("${spring.redis.timeout}")

private int timeout;

@Value("${spring.redis.jedis.pool.max-active}")

private int maxActive;

@Value("${spring.redis.jedis.pool.max-idle}")

private int maxIdle;

@Value("${spring.redis.jedis.pool.min-idle}")

private int minIdle;

@Value("${spring.redis.jedis.pool.max-wait}")

private long maxWait;

@Bean

public GenericObjectPoolConfig<Object> getGenericObjectPoolConfig() {

// 配置redis连接池

GenericObjectPoolConfig<Object> poolConfig = new GenericObjectPoolConfig<>();

poolConfig.setMaxTotal(maxActive);

poolConfig.setMaxIdle(maxIdle);

poolConfig.setMinIdle(minIdle);

poolConfig.setMaxWaitMillis(maxWait);

return poolConfig;

}

@Primary

@Bean(name = "redisTemplateDb0")

public RedisTemplate<String, Object> getRedisTemplateOfDb0() {

return getRedisTemplateByLettuceConnectionFactory(db0);

}

@Bean(name = "redisTemplateDb1")

public RedisTemplate<String, Object> getRedisTemplateOfDb1() {

return getRedisTemplateByLettuceConnectionFactory(db1);

}

@Bean(name = "redisTemplateDb2")

public RedisTemplate<String, Object> getRedisTemplateOfDb2() {

return getRedisTemplateByLettuceConnectionFactory(db2);

}

public RedisTemplate<String, Object> getRedisTemplateByLettuceConnectionFactory(int databaseIndexName) {

RedisConfiguration redisConfiguration = new RedisStandaloneConfiguration(host, port);

// 设置选用的数据库号码

((RedisStandaloneConfiguration) redisConfiguration).setDatabase(databaseIndexName);

// 设置 redis 数据库密码

((RedisStandaloneConfiguration) redisConfiguration).setPassword(password);

LettucePoolingClientConfiguration.LettucePoolingClientConfigurationBuilder builder

= LettucePoolingClientConfiguration.builder()

.commandTimeout(Duration.ofMillis(timeout));

LettucePoolingClientConfiguration lettucePoolingClientConfiguration = builder.build();

builder.poolConfig(getGenericObjectPoolConfig());

// 根据配置和客户端配置创建连接

LettuceConnectionFactory factory = new LettuceConnectionFactory(redisConfiguration, lettucePoolingClientConfiguration);

// 一定要执行下一步操作,保存配置,否则会报NPL问题

factory.afterPropertiesSet();

RedisTemplate<String, Object> redisTemplate = new RedisTemplate<>();

redisTemplate.setConnectionFactory(factory);

//使用Jackson2JsonRedisSerialize 替换默认序列化(默认采用的是JDK序列化) key采用StringRedisSerializer, value采用Jackson2JsonRedisSerializer

StringRedisSerializer stringRedisSerializer = new StringRedisSerializer();

Jackson2JsonRedisSerializer<Object> jackson2JsonRedisSerializer = new Jackson2JsonRedisSerializer<>(Object.class);

ObjectMapper om = new ObjectMapper();

om.setVisibility(PropertyAccessor.ALL, JsonAutoDetect.Visibility.ANY);

om.activateDefaultTyping(LaissezFaireSubTypeValidator.instance, ObjectMapper.DefaultTyping.NON_FINAL, JsonTypeInfo.As.WRAPPER_ARRAY);

jackson2JsonRedisSerializer.setObjectMapper(om);

redisTemplate.setKeySerializer(stringRedisSerializer);//key序列化

redisTemplate.setValueSerializer(jackson2JsonRedisSerializer); //value序列化

redisTemplate.setHashKeySerializer(stringRedisSerializer);

redisTemplate.setHashValueSerializer(jackson2JsonRedisSerializer);

redisTemplate.afterPropertiesSet();

return redisTemplate;

}

}实战

package com.vivo.PlatformBuriedPointSystem.consumer;

import com.alibaba.fastjson.JSON;

import com.mysql.cj.util.StringUtils;

import com.vivo.PlatformBuriedPointSystem.common.MyConstants;

import com.vivo.PlatformBuriedPointSystem.exception.MyException;

import com.vivo.PlatformBuriedPointSystem.mapper.BuriedPointEventRecordMapper;

import com.vivo.PlatformBuriedPointSystem.pojo.dao.BuriedPointEventRecordDao;

import com.vivo.PlatformBuriedPointSystem.pojo.dao.MessageQueueConsumptionEventDao;

import com.vivo.PlatformBuriedPointSystem.pojo.dto.BuriedPointEventRecordDto;

import lombok.extern.slf4j.Slf4j;

import org.apache.rocketmq.common.message.MessageExt;

import org.apache.rocketmq.spring.annotation.ConsumeMode;

import org.apache.rocketmq.spring.annotation.RocketMQMessageListener;

import org.apache.rocketmq.spring.core.RocketMQListener;

import org.springframework.data.redis.core.RedisTemplate;

import org.springframework.stereotype.Component;

import javax.annotation.Resource;

import java.nio.charset.StandardCharsets;

@Slf4j

@Component

@RocketMQMessageListener(topic = "topic-buriedPointEvent", consumerGroup = "consumerGroup-buriedPointEvent", consumeMode = ConsumeMode.ORDERLY)

public class BuriedPointEventRecordConsumer implements RocketMQListener<MessageExt> {

@Resource

private BuriedPointEventRecordMapper buriedPointEventRecordMapper;

@Resource(name = "redisTemplateDb2")

private RedisTemplate<String, Object> redisTemplate;

@Override

public void onMessage(MessageExt message) {

// 定义为顺序消费模式,保证每条消息,只被消费一次

// 1、确认消息是否被消费过,重复消费次数 为0,表示未被消费

if (message.getReconsumeTimes() > 0) {

return;

}

// 2、数据库通过消息ID,查询是否存在对应的消息,若存在,说明有消费记录

String messageId = message.getMsgId();

Object value = redisTemplate.opsForValue().get(messageId);

if (value != null) {

return;

}

// 3、数据库没有对应记录,则在数据库中插入对应的消息信息,并将消息的消费状态设置为 “consuming”

String messageBody = new String(message.getBody(), StandardCharsets.UTF_8);

// 3.1、如果消息体内容,为空或者null,则为异常情况

if (StringUtils.isNullOrEmpty(messageBody)) {

throw new MyException("message content is null or empty,messageBody = " + messageBody);

}

// 3.2、将消息Body解析为对应的DTO类

BuriedPointEventRecordDto buriedPointEventRecordDto = JSON.parseObject(messageBody, BuriedPointEventRecordDto.class);

// 3.3、消息内容,设置为对应DTO类的JSON 字符串

MessageQueueConsumptionEventDao messageQueueConsumptionEventDao = new MessageQueueConsumptionEventDao();

messageQueueConsumptionEventDao

.setMessageId(messageId)

.setMessageContent(JSON.toJSONString(buriedPointEventRecordDto))

.setMessageConsumptionStatus(MyConstants.MESSAGE_QUEUE_CONSUMPTION_STATUS_CONSUMING)

.setBusinessPlatform("BEGS")

.setBusinessType("vChatMessageSend")

.setTopicName("topic-buriedPointEvent");

redisTemplate.opsForValue().set(messageId, JSON.toJSON(messageQueueConsumptionEventDao));

// 4 处理具体业务

BuriedPointEventRecordDao buriedPointEventRecordDao = new BuriedPointEventRecordDao();

buriedPointEventRecordDao

.setEventId(buriedPointEventRecordDto.getEventId())

.setEventLabel(buriedPointEventRecordDto.getEventLabel())

.setUserUuid(buriedPointEventRecordDto.getUserUuid())

.setUserIp(buriedPointEventRecordDto.getUserIp());

if (buriedPointEventRecordMapper.insert(buriedPointEventRecordDao) != 1) {

throw new MyException("buriedPointEventRecordDao failed to insert");

}

// 5 以上业务若处理成功,则删除对应的消息

redisTemplate.delete(messageId);

}

}Redisson

看门狗

1.6 Spring Cloud/服务/微服务

Spring Cloud 的项目核心目标,就是提供一套完整的微服务架构解决方案。它定义了一套标准的、抽象的客户端接口。

1.6.1 Feign

什么是 Feign?

Feign 是 Netflix 开源的一个声明式 HTTP 客户端库,Spring Cloud 对其进行了二次封装(Spring Cloud OpenFeign)。

它能让你把远程 HTTP 接口 “像本地方法” 一样调用:只需定义一个 Java 接口,添加几个注解,就能完成序列化、反序列化、请求构造、负载均衡、熔断等一系列工作。

- 简洁:不用手写

RestTemplate、HttpClient代码,避免重复造轮子。 - 声明式:接口与注解就能定义 API,代码可读性高。

- 可扩展:支持超时、拦截器、错误解码、调用重试、熔断降级等。

- 与 Spring Cloud 生态集成:自动结合服务发现、负载均衡(Ribbon/LoadBalancer)、熔断(Hystrix/Resilience4j)等。

在项目中引入 Feign

依赖(以 Spring Cloud Alibaba 为例)

<dependency> <groupId>org.springframework.cloud</groupId> <artifactId>spring-cloud-starter-openfeign</artifactId> <version>${spring-cloud-starter-openfeign.version}</version> </dependency>启动类上开启 Feign

@SpringBootApplication

@EnableFeignClients // 扫描并注册所有带 @FeignClient 的接口

public class Application { … }定义 Feign 客户端接口

@FeignClient(

name = "file-service-center-api",

url = "${host.file-service-center}",

configuration = FeignConfig.class

)

public interface FileServiceCenterBackEndClient {

@PostMapping(value = "/upload/singleFile", consumes = MediaType.MULTIPART_FORM_DATA_VALUE)

BaseResult uploadSingleFile(

@RequestPart("file") MultipartFile file,

@RequestPart("uploadSingleFileDto") UploadSingleFileDto dto);

// … 其他接口方法 …

}直接指定url是不会通过注册中心发送请求的,是直接请求。

对比手动拼装 HTTP 请求优势

代码量:手动拼装 HTTP 请求需显式构造 URL、头部、请求体和异常处理;Feign 只需定义接口和注解,自动完成序列化、反序列化和调用逻辑。

关注点分离:手动方式让业务代码混进大量网络细节;Feign 客户端将网络调用抽象为接口,业务层只聚焦核心逻辑。

统一配置:超时、重试、日志等要在每次调用处或底层工具中单独配置;Feign 只在一个配置类(FeignConfig)里集中管理。

生态集成:手动方式要自己接入并配置 Ribbon、熔断、监控等;Feign 与 Spring Cloud 深度整合,这些能力开箱即用。

可测试性:手动调用需要模拟 HTTP 服务器或 mock RestTemplate;Feign 接口可直接用 @MockBean 或 Mockito 轻松替代。

核心注解属性

| 属性 | 含义 |

|---|---|

| name | FeignClient 的逻辑名称,也同时作为 Spring Bean 名称(默认小写接口名)。 如果不指定 url,就会把它当作注册中心的服务 ID 去发现实例:根据 name 去注册中心找对应的服务,针对服务下的 host 轮询或随机请求。 |

| url | 目标服务的基础 URL。 - 每个方法上的映射路径(如 /upload/singleFile)会拼接到这里。 |

| configuration | 指定仅应用于本 FeignClient 的配置类。 可以集中管理超时、拦截器、编码解码器、错误处理等。 |

统一配置:FeignConfig

@Configuration

public class FeignConfig {

@Bean

public Request.Options options() {

return new Request.Options(10L, TimeUnit.SECONDS, 300L, TimeUnit.SECONDS, true);

}

}使用方法

@Service

public class MyBusinessService {

private final FileServiceCenterBackEndClient fileClient;

public MyBusinessService(FileServiceCenterBackEndClient fileClient) {

this.fileClient = fileClient;

}

public void processAndUpload(MultipartFile file) {

UploadSingleFileDto dto = new UploadSingleFileDto(/* 填充你的参数 */);

BaseResult result = fileClient.uploadSingleFile(file, dto);

if (!result.isSuccess()) {

throw new BusinessException("上传失败:" + result.getMessage());

}

// 继续后续业务

}

}1.6.2 服务间通信 / 远程服务调用

服务发现(Service Discovery)

Http客户端(Feign)通过客户端均衡负载(Ribbon / Spring Cloud LoadBalancer)向注册中心(Eureka/Consul)查询“我想调用的服务名对应哪些健康实例”。

客户端负载均衡(Client‑Side Load Balancing)

拿到实例列表后,按轮询、随机、加权等策略在本地选一台机器。

远程调用(Remote Call)

由 Feign 声明式地构造和发送 HTTP 请求,发送到选中的实例地址,并处理响应。

1.6.3 HTTP 客户端

| 客户端 | 类型 | 声明式支持 | 底层实现 | 优缺点 | 适用场景 |

|---|---|---|---|---|---|

| Feign / OpenFeign | 同步/阻塞 | 原生支持 | 可插拔(默认 OkHttp / Apache HttpClient) | + 接口注解化、集成 Ribbon/Eureka+ 自动序列化/反序列化– 性能受限于底层 HTTP 客户端 | Spring Cloud 微服务间远程调用 |

| RestTemplate | 同步/阻塞 | 无 | HttpURLConnection / Apache HttpClient | + 简单易用– Spring5 后被标为过时,不再增强 | 传统 Spring MVC 项目(简单场景) |

| Apache HttpClient | 同步/阻塞 | 无 | Apache HttpClient | + 功能全面、配置灵活– 框架较重,配置繁琐 | 需要高级连接池、SSL、代理等控制的场景 |

| OkHttp | 同步/阻塞 | 无 | OkHttp | + 性能高、友好连接池+ 支持 HTTP/2、WebSocket– Java 服务端需显式引入 | 高并发服务端、Android 客户端 |

| Java 11+ HttpClient | 同步/阻塞 | 无 | JDK 内置 | + 零额外依赖、API 现代化– 功能基础,某些高级需求需自行扩展 | 简单 HTTP 调用,无需第三方依赖 |

| JAX‑RS Client | 同步/阻塞 | 注解驱动 | Jersey / RESTEasy | + 规范化、可替换实现– 学习和配置成本比 RestTemplate 略高 | Jakarta EE / JAX‑RS 生态 |

| WebClient | 异步/反应式 | 部分支持 | Reactor + Netty | + 反应式、支持流式处理+ 资源利用高– 编程模型复杂度高 | 高并发、流式数据、响应式微服务 |

| AsyncHttpClient | 异步/回调 | 无 | Netty | + 超高吞吐、低延迟– API 回调式,使用复杂 | 极端性能场景 |

| Vert.x WebClient | 异步/回调 | 无 | Vert.x Event Loop | + 轻量、集成 Vert.x 生态– 依赖 Vert.x | Vert.x 应用 |

| Retrofit | 同步/阻塞 + 异步 | 原生支持 | OkHttp | + 注解化、灵活易用+ Android 社区成熟– 服务发现/负载均衡需手动集成 | Android 客户端/轻量 Java 服务端 |

| Reactive Feign | 异步/反应式 | 原生支持 | WebClient | + 声明式 + 反应式– 社区生态较新,文档稍少 | 需要声明式接口同时享受反应式 I/O 的场景 |

1.6.4 服务发现与负载均衡

注意:Nginx 是一个传统的 反向代理服务器,它可以通过 DNS 或配置文件指向多个后端服务实例,进行负载均衡(例如,轮询、IP 哈希、加权等)。但是,它并没有像 Ribbon、Spring Cloud LoadBalancer 等那样与服务注册中心直接集成,不具备服务发现功能。

| 特性 / 方案 | Ribbon + Eureka | Spring Cloud LoadBalancer + Discovery Client | Kubernetes DNS + Envoy 或 Istio | API Gateway(Nginx、Zuul、Spring Cloud Gateway) | gRPC + xDS |

|---|---|---|---|---|---|

| 现状 | Netflix Ribbon 已维护模式,不推荐新项目使用 | 官方推荐,用 Spring Boot Starter 即可接入 | 服务网格(Service Mesh)主流方案,适合大规模集群 | 侧重于“边缘路由+熔断” | gRPC 官方推荐的动态负载均衡接口 |

| 服务发现集成 | Eureka / Consul / ZK(注册中心) | 同上 | Kubernetes API Server(通过 sidecar 自动同步) | 通常和 Eureka、Consul、Kubernetes 集成 | xDS 握手至控制平面(Envoy / Istio 控制面) |

| 依赖组件 | spring-cloud-starter-netflix-ribbon | spring-cloud-starter-loadbalancer + discovery | Istio / Linkerd / Consul Connect | Spring Cloud Gateway、Nginx、Zuul | grpc-java + grpc-xds |

| 负载均衡策略 | 轮询、随机、权重、最少并发 | 同 Ribbon,可自定义 | 在 Envoy sidecar 里配置,支持更丰富的 LB 策略(重试、熔断、镜像) | 主要做路由匹配、限流、熔断,LB 能力弱 | 支持轮询、最少连接、权重等,由 Envoy 或 gRPC 客户端实现 |

| 推荐客户端 | - RestTemplate + @LoadBalanced- Feign + Ribbon |

- Feign + Spring Cloud LoadBalancer- WebClient + Spring Cloud LoadBalancer | - 原生 HTTP 客户端(OkHttp / JDK HttpClient / WebClient)- gRPC-Web via Envoy | - 任意 HTTP 客户端(RestTemplate / WebClient / OkHttp)- gRPC 客户端(若网关支持) | - gRPC Java Client + xDS- Envoy gRPC-Web + HTTP 客户端 |

| 流量控制 & 可观测性 | 基础 | 基础 | 丰富:mTLS、Tracing、Metrics、流量镜像、金丝雀发布 | 基础到中等;Gateway 支持限流、熔断 | Envoy 提供,可结合 Service Mesh |

| 运维复杂度 | 低 | 低 | 高:需要额外组件(Istio)、学习成本和运维成本较高 | 中:部署和维护 Gateway | 中:需部署 xDS 控制面和 Envoy sidecar |

| 适用场景 | 小规模微服务,快速上手 | 推荐所有 Spring Cloud 项目 | 大规模集群、零信任安全、高级流量管理需求 | 边缘网关、路由聚合 | 高性能 RPC、双向流、跨语言服务发现 |

1.6.5 注册中心

在微服务架构中,注册中心(Service Registry/Discovery Server)是负责管理和提供“服务名称 ↔ 实例地址”映射关系的关键组件。

它的核心使命是让“调用方”能够动态地找到“被调用方”——而无需硬编码 IP 或端口。

注册中心本质上是分布式内存数据结构,为秒级心跳和查询提供高性能

注意,一些服务发现和负载均衡方式无需单独使用注册中心,如选用 gRPC + xDS,就把注册/发现功能交给 xDS 控制平面,不再需要像 Eureka/Nacos 那样单独部署注册中心。

| 注册中心 | 类型 | 存储机制 | 健康检查 | 数据一致性 | 配置管理 | 生态集成 | 典型使用场景 |

|---|---|---|---|---|---|---|---|

| Nacos | 一体化平台 | 内存 + 持久化 | 心跳 + 可自定义探活 | 最终一致 | ✅(灰度、命名空间) | Spring Cloud Alibaba、Dubbo | 国内微服务 + 动态配置 |

| Eureka | 服务发现 | 内存 + 自我保护 | 心跳 | 最终一致 | ❌ | Spring Cloud Netflix | 中小规模 Spring Cloud |

| Consul | KV + 服务发现 | Raft 分布式存储 | HTTP/TTL、TCP 探活 | 强一致(Raft) | ✅(KV 存储) | 多语言、DNS、Envoy、Nomad | 弹性伸缩、跨语言微服务 |

| ZooKeeper | 通用协调 | Zab 协议 | 临时节点 + Watch | 强一致(Zab) | ❌ | Kafka、HBase、Dubbo | 需要严格一致性的元数据管理 |

| etcd | 分布式 KV | Raft 协议 | TTL 租约 | 强一致(Raft) | ✅(简单 KV) | Kubernetes、CoreDNS | Kubernetes 控制面、云原生架构 |

| Kubernetes DNS | 内置服务注册 | API Server → CoreDNS | Pod/Service 状态 | 强一致(etcd) | ❌ | Kubernetes 原生 | 容器化集群下的“零配置”服务发现 |

| AWS Cloud Map | 托管服务 | AWS Route 53 DNS | AWS Health Check | 最终一致 | ✅(Parameter Store) | ECS/EKS、Lambda | AWS 原生托管微服务 |

| Azure Service Fabric | 平台内置 | Reliable Collections | Fabric Health | 强一致 | ✅(Config API) | Service Fabric 环境 | Azure Service Fabric 集群 |

| gRPC + xDS | RPC 控制面 | 控制平面 + Envoy | Envoy 健康检查 | 最终一致/强一致 | ❌ | Istio、Envoy | 高性能双向流、跨语言 RPC 场景 |

nacos

Nacos(全称 Dynamic Naming and Configuration Service)是阿里巴巴开源的一个一站式服务发现、配置管理和服务治理平台,主要用于微服务架构下的服务发现与管理。Nacos 提供了服务注册、配置管理、动态 DNS 和健康检查等功能,帮助开发者实现微服务的灵活管理和高可用性。

核心功能

- 服务发现与注册

- 微服务在启动时,自动向 Nacos 注册其服务信息(如服务名、IP、端口、元数据等)。

- 服务调用方可以通过 Nacos 查找并获取服务的实例列表,支持自动负载均衡。

- 支持主动的健康检查,当某个服务实例不可用时,Nacos 会及时从注册列表中移除,避免发送请求到不可用的服务。

- 动态配置管理

- Nacos 可以集中管理应用的配置信息(如数据库连接信息、API 密钥、业务参数等)。

- 提供 灰度发布、版本控制、多环境支持,可以方便地进行配置更新,且支持 热更新(无需重启应用)。

- 支持 命名空间、分组、配置多层级管理。

- 服务健康监测

- Nacos 会定期对注册的服务实例进行健康检查,确保服务在失效时能及时剔除并通知消费者。

- 健康检查支持基于 HTTP、TCP、DNS 等协议,可以非常灵活地设置。

- 动态 DNS 服务

- 提供基于服务名的 DNS 解析,可以通过标准的 DNS 协议来访问服务实例,实现服务的快速发现和动态调整。

- 支持多种协议

- 支持通过 HTTP、gRPC、Dubbo 等协议进行服务通信,并为这些协议提供良好的集成支持。

- 支持 Kubernetes 集群

- Nacos 可以与 Kubernetes 集成,自动注册 Kubernetes Pod 为服务实例,实现服务的自动发现和管理。

spring:

# 数据库

datasource:

driver-class-name: com.mysql.cj.jdbc.Driver

url: jdbc:mysql://IP:3306/fluency?useSSL=false&characterEncoding=UTF-8&allowPublicKeyRetrieval=true&allowMultiQueries=true&serverTimezone=Asia/Shanghai

username: xxxx

password: xxxx

# nacos 注册名称

application:

name: Dev-begs-07-case-collection-system

cloud:

nacos:

discovery:

# Nacos 注册中心的地址

server-addr: IP:8848

group: DEFAULT_GROUP配置了 spring.application.name 和 server-addr 后,Spring Boot 应用会自动把自己注册到 Nacos 的 服务注册中心。

配置之后,Feign只写name不写url会自动从Nacos里发现服务。

1.6.6 网关

所有外部请求进入微服务系统的唯一入口,负责对请求进行统一的管理、检查和路由。

统一入口 (Single Entry Point)

功能:所有客户端(App、浏览器)只与网关交互,不知道也不需要知道内部有哪些微服务以及它们的地址。

好处:解耦客户端与后端服务。后端服务可以随时拆分、合并、升级、迁移,只要网关的路由规则相应改变,客户端无需任何修改。

身份认证与授权 (Authentication & Authorization)

功能:在网关层统一验证用户身份(登录态Token是否有效)、检查用户是否有权限访问目标资源。

好处:避免每个微服务都重复实现一套鉴权逻辑,保证安全策略的一致性。非法请求在进入内部网络前就被拦截。

路由转发 (Routing)

功能:根据请求的路径(如

/api/users/**)、方法(GET/POST)等,将请求转发到对应的后端微服务实例。好处:网关集成服务发现功能(如Nacos、Eureka),能自动找到健康的服务实例,并实现负载均衡。

流量控制与熔断 (Rate Limiting & Circuit Breaker)

功能:

限流:限制每个用户/IP在一段时间内的请求次数,防止恶意攻击或流量洪峰冲垮系统。

熔断:当某个后端服务响应慢或大量失败时,网关可以暂时停止向其转发请求(熔断),直接返回一个预设的降级响应,避免故障扩散。

好处:保护后端服务,提升系统整体的弹性和可用性。

日志记录与监控 (Logging & Monitoring)

功能:作为所有流量的必经之地,网关可以统一收集请求和响应日志、监控API性能(耗时、QPS、错误率等)。

好处:为排查问题、分析数据和系统优化提供 centralized 的数据支持。

其他常用功能

请求/响应转换:对请求进行修改、校验、包装,或对响应进行过滤、聚合。

SSL 终端:在网关处理HTTPS加密/解密,减轻后端服务的压力。

缓存:缓存一些频繁请求的静态数据或结果。

服务拆分

1.7 Spring / Springboot

Spring是一个强大的Java开发框架,提供了一系列的应用模块支持需求,包括依赖注入、面向切片编程、事务管理、web应用程序开发等。

Springboot简化了Spring应用程序的开发和部署,相当于全自动洗衣机,特别是用于微服务和快速开发的应用程序。

Springboot的优势:

自动配置

Spring Boot 通过Auto-Configuration来减少开发人员的配置工作。我们可以通过一个starter就把依赖导入,启动时会根据项目中引入的 Jar 包,自动为项目配置所需的 Bean。从而告别繁琐配置:无需手动写 @Configuration或 XML 来配置 DataSource、TransactionManager、MVC 等组件。

内嵌Web服务器

Spring Boot内置了常见的Web服务器(如Tomcat、Jetty),这意味着您可以轻松创建可运行的独立应用程序,而无需外部Web服务器。

约定大于配置

SpringBoot中有很多约定大于配置的思想的体现,通过一种约定的方式,来降低开发人员的配置工作。如他默认读取spring.factories来加载Starter、读取application.properties或application.yml文件来进行属性配置等

1.7.1 日志

1.7.1.1 Logback

logback 是 Spring Boot 自带的默认日志框架,允许你快速自定义日志输出行为,尤其是日志的文件存储、滚动策略等。

配置如下:

# 日志配置

logging:

file:

# 日志文件的保存路径

name: F:/0_GerritProject/1_NewServerFluencySystem/000_logFile/07_CaseCollectionSystem_BackEnd/CaseCollectionSystem_${server.port}.log

# 滚动策略配置

logback:

rollingpolicy:

# 应用启动时,清除历史日志

clean-history-on-start: true

# 日志历史保存的最大天数

max-history: 14

max-file-size: 500MB**name**:日志文件的保存路径。

1.7.1.2 与nohup对比

nohup 输出:

- 主要捕获应用程序的 控制台输出,捕获标准输出和标准错误输出(println)。

- 输出内容较为基础,主要包括启动信息、异常堆栈、调试信息等。

- 没有自定义日志格式或结构化输出。

Spring Boot 日志:

- 包含应用的详细日志信息,如业务日志、请求日志、异常堆栈、日志级别(

INFO、DEBUG、ERROR)等。 - 使用 Logback 等日志框架,支持更丰富的日志格式、日志滚动策略、历史日志管理等。

1.7.2 AOP

1.7.2.1 AOP 封装回滚

@Transactional(rollbackFor = Exception.class)1.7.3 事务

[受检异常](#1.11.2 Exception(受检异常)-Java异常)默认不会回滚,需要加 rollbackFor = Exception.class

@Transactional // 不写 rollbackFor:只回滚 RuntimeException

public void foo() throws IOException {

dao.insertA();

if (true) throw new IOException(); // 受检异常 -> 默认不回滚(会提交!)

}

@Transactional(rollbackFor = Exception.class)

public void bar() throws IOException {

dao.insertA();

if (true) throw new IOException(); // 受检异常 -> 回滚

}1.7.4 监控

Spring Boot Actuator

Spring Boot Actuator 是 Spring 官方提供的 应用监控与管理模块。

它会自动暴露一批 REST 风格的监控端点(默认在 /actuator 下),让你能实时查看和管理应用的运行状态。

常见端点:

/actuator/health—— 健康检查(UP/DOWN),常被 K8s、监控系统探活用。/actuator/metrics—— 各种指标(JVM 内存、线程、HTTP 请求数、GC 次数等)。/actuator/env—— 环境属性(系统变量、配置文件里的值)。/actuator/beans—— Spring 容器里的 Bean 列表。/actuator/mappings—— 所有请求映射(controller 的 URL → 方法)。/actuator/loggers—— 动态查看/修改日志级别。

👉 它是开发运维常用的 应用可观测性工具。

如何引入

在 pom.xml 里加:

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-actuator</artifactId>

</dependency>1.8 分布式开发

1.8.1 分布式定时任务

1.8.1.1 单机定时任务

@Scheduled(cron = "0 0/5 * * * ?")

public void report() {

System.out.println("每5分钟执行一次任务");

}如果只部署在一台服务器 上,它就能正常执行。但是如果部署了多台机器(微服务集群),这个任务会在每台机器上都跑一遍,这样就会重复执行,数据错乱。

1.8.1.2 分布式定时任务

目标:多台机器同时部署时,保证一个任务只执行一次(或按分片规则分配执行)。

主要有两种模式:

1.8.1.2.1 单点调度

- 只有 一个调度中心(比如 XXL-JOB 的 Admin)。

- 调度中心负责根据 cron 触发任务,并决定派发给哪台执行器。

- 这样就不会出现 “多台机器重复执行” 的问题。

1.8.1.2.2 分片执行

- 有些任务很大,比如要处理 100 万条数据。

- 可以把任务分成 N 份,分给集群里的不同机器并行跑,加快速度。

- 比如 10 台机器,每台机器只处理 1/10 的数据。

1.8.1.3 Xxl-Job

Admin(调度中心)

- 提供一个 控制台网站(本质是一个 Spring Boot 项目)。

- 你在里面配置任务:什么时候跑、在哪些机器跑、失败了怎么重试、保留多少天日志…

- 作用像“管理者”:下达指令,并收集执行结果、日志。

Executor(执行器)

- 就是你们自己的 业务服务(Spring Boot 项目里引入

xxl-job-core),在里面写任务方法。 - 执行器会注册到 Admin,告诉 Admin:“我在这里,有 CPU 可以跑任务”。

- 当时间到时,Admin 触发调度,执行器就去跑任务。

- 执行完毕后,执行器会回调 Admin,告诉它“任务完成/失败了”。

分布式调度(高可用性)

调度中心本身可以部署多个实例,前面挂一个负载均衡(Nginx)。

同一时刻只有一个 Admin 节点触发任务,因为调度中心依赖数据库的分布式锁保证“只有一个节点触发”。

即使一个节点宕机也不影响其他节点继续触发任务,存活的 Admin 会继续抢到锁并触发。

分布式执行(并行加速)

当调度中心触发任务时,Admin 会并行通知 5 个执行器实例,每个实例只处理自己的一部分数据。这样原先2小时的工作可能5分钟内完成。

实例 1 → 处理用户 ID 0~199999

实例 2 → 处理用户 ID 200000~399999

…

实战

在 MySQL / PostgreSQL 里先手动建一个数据库(比如叫 xxl_job),执行 XXL-JOB 提供的建表脚本(/xxl-job/doc/db/tables_xxl_job.sql)来创建表结构。

方法一(docker拉取调度中心)

docker pull xuxueli/xxl-job-admin:3.1.1

/**

* 如需自定义 mysql 等配置,可通过 "-e PARAMS" 指定,参数格式 PARAMS="--key=value --key2=value2" ;

* 配置项参考文件:/xxl-job/xxl-job-admin/src/main/resources/application.properties

* 如需自定义 JVM内存参数 等配置,可通过 "-e JAVA_OPTS" 指定,参数格式 JAVA_OPTS="-Xmx512m" ;

*/

docker run -e PARAMS="--spring.datasource.url=jdbc:mysql://127.0.0.1:3306/xxl_job?useUnicode=true&characterEncoding=UTF-8&autoReconnect=true&serverTimezone=Asia/Shanghai" -p 8080:8080 -v /tmp:/data/applogs --name xxl-job-admin -d xuxueli/xxl-job-admin:{指定版本}方法二(拉取源码,自行部署调度中心)

spring:

application:

name: xxl-job-admin

mvc:

servlet:

load-on-startup: 0

static-path-pattern: /static/**

web:

resources:

static-locations: classpath:/static/

freemarker:

template-loader-path: classpath:/templates/

suffix: .ftl

charset: UTF-8

request-context-attribute: request

settings:

number_format: 0.##########

# 配置数据源

datasource:

url: jdbc:mysql://IP:3306/xxl_job?useSSL=false&characterEncoding=UTF-8&allowPublicKeyRetrieval=true&allowMultiQueries=true&serverTimezone=Asia/Shanghai

username: xxxuser

password: xxxx

driver-class-name: com.mysql.cj.jdbc.Driver

type: com.zaxxer.hikari.HikariDataSource

hikari:

minimum-idle: 10

maximum-pool-size: 30

auto-commit: true

idle-timeout: 30000

pool-name: HikariCP

max-lifetime: 900000

connection-timeout: 10000

connection-test-query: SELECT 1

validation-timeout: 1000

# 报警邮箱

# 任务失败告警:当某个任务在执行过程中报错、超时或多次重试仍失败时,XXL-JOB 会根据任务配置,把失败信息发送到预设的邮箱。

# 调度异常告警:如果执行器机器掉线、注册失败或者触发调度线程池出错,也可以触发告警邮件。

# 报警内容:任务名称 / JobHandler;执行时间、失败次数;错误堆栈或日志片段;对应执行器实例信息

mail:

host: smtp.qq.com

port: 25

from: xxx@qq.com

username: xxx@qq.com

password: xxx

properties:

mail:

smtp:

auth: true

starttls:

enable: true

required: true

socketFactory:

class: javax.net.ssl.SSLSocketFactory

xxl:

job:

# 调度中心通讯TOKEN [选填]

accessToken: default_token

# 执行器与调度中心之间 HTTP 通讯的超时时间[选填],默认3s;

timeout: 3

# 调度中心国际化配置 [必填]

i18n: zh_CN

# 调度线程池最大线程配置,限制 Admin 调度中心最多能同时并发触发多少个任务【必填】

triggerpool:

# 快速任务触发(如果耗时 < 500ms → 判定为 fast 任务,以后再触发就丢进 fast 线程池)

fast:

max: 200

slow:

max: 200

# 调度中心日志表数据保存天数 [必填]:过期日志自动清理;限制大于等于7时生效,否则, 如-1,关闭自动清理功能;

logretentiondays: 30admin节点分布式部署

多 Admin 实例:2~3 个即可。

同一数据库:所有 Admin 指向同一 MySQL(用官方 xxl_job.sql 初始化)。

统一 accessToken:所有 Admin/Executor 的 accessToken 要一致。

负载均衡:使用 Nginx / SLB / K8s Service 做均衡负载,暴露 Nginx(或云 SLB)对外的端口号。

会话问题:控制台登录会话要么开负载均衡粘性会话,要么接 Spring Session + Redis 共享会话。

执行器指向多 Admin:xxl.job.admin.addresses 写成LB(Load Balancer) 地址或多个地址逗号分隔。

Elastic-Job

1.9 Java

1.9.1 Java 中的数据定义

在 Java 里,从底层来看,可以分成两类:

1.9.1.1 基本类型 (Primitive Types)

- 一共 8 种:

byte, short, int, long, float, double, char, boolean。 - 直接存放在 栈(stack frame 的局部变量表)或者 数组的连续内存块里。

- 不存在“引用”,值就是本身。

int[]数组里存放的就是裸的 32 位整型值。

int a = 10; // a 直接存放值 10

int[] arr = {1,2}; // arr 是对象引用,但 arr[0] 存放的是裸的 32 位 int1.9.1.2 引用类型 (Reference Types)

- 包括:所有类(

String、Integer、ArrayList等)、接口、数组本身(int[]、String[]等,数组本身是对象)、泛型类型:如List<String>本身就是一个引用类型。 - 在变量里存放的是一个 引用(指针),指向堆 (heap) 上的对象实例。

- 比如:

ArrayList<Integer>对象里存放的其实是一个Integer[]数组,而Integer又是对象,最终还是存引用。

String s = "hello"; // s 是引用,指向堆中 String 对象

Integer n = 10; // 自动装箱,n 是引用,指向堆中 Integer 对象

String[] arr = new String[5]; // arr 是引用,arr[i] 存放引用(默认 null)1.9.1.2.1 接口 (Interface Types)

定义:接口是一种特殊的引用类型,定义了一组方法规范,但不提供实现。

存储方式:接口变量本质上还是一个 对象引用,指向某个实现了该接口的类的实例。

特点:

不能直接 new 一个接口。

常用于 面向接口编程,解耦实现与调用。

例子:

如下所示,类型在初始化的时候决定,不在左侧写死。

泛型类型参数 <T> 里的 T 必须是引用类型,不可以是基本类型

// list 是 List 接口类型的引用,右边的对象是 ArrayList 实例

List<Integer> list = new ArrayList<>();

List<int[]> list = new ArrayList<>();

list.add(new int[]{1,2,3});

list.add(new int[]{4,5});

// 取出一个元素

int[] arr = list.get(0);

System.out.println(arr[0]); // 输出 1

1.9.1.2.2 泛型 (Generics)

泛型是 Java 提供的一种 类型参数化机制。

传统的类/方法里,类型是写死的;泛型允许你把 类型当作参数 传进去。

换句话说:泛型就是让类型像方法里的变量一样可以被传入。

class Box<T> { // 这里的 Box 就是一个泛型类,T 是类型参数

private T value;

public void set(T value) { this.value = value; }

public T get() { return value; }

}Box<T> → 泛型类型(未具体化的形式)

Box<String> → 泛型类型的一个 实例化形式(concrete parameterization)

T 就是 类型参数,调用时要替换成某个具体的引用类型。

// Java 7 之前必须写全

List<String> list = new ArrayList<String>();

// Java 7+ 支持菱形语法 <>

// ()是该类的构造函数调用

List<String> list = new ArrayList<>();1.9.2 JVM

1.9.3 线程

13分支,多线程编程

1.9.3.1 什么是线程安全

以原生数组为例,它并不是线程安全的。

Java 数组(int[]、Object[] 等)底层就是一块连续内存,JVM 并不会对它的读写加锁。

如果多个线程同时访问数组 只读 → 是安全的(因为不会修改数据)。

如果有线程在 写数组,而其他线程也在读/写 → 就会产生数据竞争,可能读到脏数据、覆盖写入等。

1.9.3.2 如何保证线程安全

1.9.3.2.1 互斥/加锁

通过一种协议,保证在同一时刻,只有一个线程可以访问某个共享资源或代码段(称为临界区)

synchronized关键字 (Java): 可用于修饰方法或代码块。JVM 负责底层的锁的获取和释放,是一种监视器锁。

public class Counter {

private int count = 0;

// 同步方法(锁是当前实例对象 this)

public synchronized void increment() {

count++; // 这个操作现在是原子的

}

// 同步代码块(可以指定不同的锁对象,更灵活)

public void decrement() {

synchronized (this) {

count--;

}

}

}ReentrantLock (Java): 一个显式的锁实现,提供了比 synchronized更灵活的功能,如可重入性、可中断的锁等待、公平锁、尝试获取锁等。

import java.util.concurrent.locks.Lock;

import java.util.concurrent.locks.ReentrantLock;

public class Counter {

private int count = 0;

private Lock lock = new ReentrantLock();

public void increment() {

lock.lock(); // 手动获取锁

try {

count++;

} finally {

lock.unlock(); // 必须在finally块中确保释放锁

}

}

}1.9.3.2.2 并发安全的数据结构

这些数据结构在内部已经实现了所有必要的同步机制(通常使用了非常精细的锁策略或无锁技术),使得它们的每个公共方法调用都是原子的。开发者无需再额外加锁。

它们通过内部复杂的实现(如分段锁、CAS)来保证多线程环境下数据的一致性和可见性。

具体实现 (Java java.util.concurrent包):

- **

ConcurrentHashMap**: 代替HashMap和Hashtable。它使用分段锁(Java 7)或 CAS +synchronized(Java 8+),实现了极高的并发访问性能。 CopyOnWriteArrayList/CopyOnWriteArraySet**: 采用“写时复制”策略。每次修改(写)操作都会创建底层数组的一个新副本。读操作完全无锁,性能极高。适用于读多写少**的场景。- **

ConcurrentLinkedQueue**: 一个高效的无界非阻塞线程安全队列,使用 CAS 操作实现。 BlockingQueue接口 (ArrayBlockingQueue,LinkedBlockingQueue): 提供了“阻塞”的插入和取出操作,是实现生产者-消费者模型的利器。

优点: 使用简单,性能通常比自己写的粗粒度锁要好得多。

缺点: 需要注意它们的特定语义(如 CopyOnWriteArrayList的最终一致性),且多个方法的组合调用不是原子的(例如,先 concurrentMap.contains(key)再 concurrentMap.put(key, value)需要额外同步)。

1.9.3.2.3 原子变量 / CAS 操作

这是实现无锁并发算法的底层基础,是很多并发安全数据结构的构建基石。

核心思想: 比较并交换。这是一种硬件级别的原子操作(通常由 CPU 指令支持)。它的行为是:“如果变量 V 的值等于预期值 A,那么就将其原子性地更新为新值 B,否则什么都不做并返回当前值”。

如何具体保证安全: 它避免了昂贵的锁开销,通过乐观锁的策略。它假设竞争不激烈,先尝试更新,如果发现值已经被其他线程修改过(与预期值 A 不符),则失败重试。这个循环重试的过程通常称为 自旋。

具体实现 (Java

java.util.concurrent.atomic包):AtomicInteger,AtomicLong,AtomicBooleanAtomicReference<T>AtomicStampedReference<T>: 解决了 CAS 的 ABA 问题(一个值从 A 变成 B 又变回 A,CAS 会误以为它没变过)。import java.util.concurrent.atomic.AtomicInteger; public class Counter { // 使用原子变量,无需锁 private AtomicInteger count = new AtomicInteger(0); public void increment() { // 内部基于 CAS 实现 count.incrementAndGet(); } // 一个复杂的 CAS 示例:只有当前值是 10 时才将其设置为 0 public void resetIfTen() { int oldValue; do { oldValue = count.get(); // 获取当前值 } while (oldValue == 10 && !count.compareAndSet(oldValue, 0)); // 如果当前值不是10,或者CAS设置成功,则退出循环 } }

优点: 性能极高(在低竞争环境下),避免了死锁。

缺点: 在高竞争环境下,自旋会严重消耗 CPU。实现复杂的逻辑(涉及多个变量)非常困难,通常需要求助于锁。

1.9.3.2.4 不可变性(Immutable)

一个对象在构造完成后,其状态就永远无法被修改。如果需要一个新状态,就创建一个全新的对象。

如何具体实现不可变类 (以 Java 为例):

- **将类声明为

final**,防止子类破坏不可变性。 - **将所有字段声明为

private final**。 - 不提供任何可以修改对象状态的方法(即

setter方法)。 - 通过构造器初始化所有字段。如果字段是可变对象的引用,需要进行防御性拷贝。

1.9.4 JPA

JPA(Java Persistence API)是Sun官方(现Oracle)提出的Java持久化规范。它本身是一个标准、一套接口,而不是具体的实现。

可以从ORM、@注解、

ORM(对象关系映射)

Hibernate 是 JPA 的一个主要实现,是“全ORM”框架。而 MyBatis 被认为是一个“半ORM”或“SQL映射”框架,xml最终会映射成sql语句。半ORM框架在对象关系映射(ORM)过程中保留了开发者对 SQL 的完全控制权。而全自动ORM可能要查好几次数据库,不如直接一句SQL查询到位。

将数据库中的表(Table)映射为Java中的实体类(Entity Class)。

将表中的字段(Column)映射为实体类的属性(Field)。

将表中的记录(Row)映射为实体类的对象(Instance)。

通过操作对象,最终由JPA实现框架生成SQL语句并执行,开发者无需编写繁琐的JDBC代码。

元数据注解(Metadata Annotations)

JPA通过注解来配置映射关系,极大简化了配置。这是它比早期Hibernate的XML配置更受欢迎的原因。

常用注解

@Entity: 标明这是一个需要与数据库映射的实体类。

@Table: 指定映射的表名。

@Id: 标明主键字段。

@GeneratedValue: 指定主键生成策略(如自增、UUID等)。

@Column: 指定映射的列名和约束。

@ManyToOne, @OneToMany, @ManyToMany, @OneToOne: 定义表之间的关联关系。

EntityManager:核心接口

这是JPA操作实体的核心接口,相当于Hibernate中的Session或JDBC中的Connection。

它的生命周期由EntityManagerFactory创建和管理。

主要功能:

CRUD操作: persist(entity)(新增), find(class, id)(查询), merge(entity)(更新), remove(entity)(删除)。查询: 创建Query对象执行JPQL。事务管理: 相关操作通常在事务(@Transactional)内进行。缓存管理: 维护一级缓存(Persistence Context),保证在同一上下文中的对象唯一性。

// JPA标准接口 (由Hibernate实现)

EntityManager em = entityManagerFactory.createEntityManager();

// 插入对象 → 自动生成INSERT

em.persist(user);

// 查询对象 → 自动生成SELECT

User u = em.find(User.class, 1L);

// 更新对象 → 自动生成UPDATE

u.setName("Bob");

em.merge(u);

// 删除对象 → 自动生成DELETE

em.remove(u);JPQL(Java Persistence Query Language)

这是一种面向对象的查询语言,语法类似于SQL,但操作的是实体对象和属性,而不是数据库的表和字段。例子: SELECT u FROM User u WHERE u.name = :name优势: 数据库无关性,更符合面向对象的思维。JPA实现会将其翻译成特定数据库的SQL。

持久化上下文(Persistence Context)与缓存

一级缓存: 即EntityManager内部的缓存。在一个事务内,对同一实体对象的多次操作会被缓存和优化,最终可能只生成一条UPDATE SQL,这被称为“脏检查”(Dirty Checking)。二级缓存: 应用级别的缓存,属于EntityManagerFactory,可以被多个EntityManager共享。需要额外的配置和缓存提供商(如Ehcache)。

1.9.5 JDBC

JDBC 是 Java Database Connectivity 的缩写,意为 Java 数据库连接。它是一套标准的 Java API,用于连接和执行 SQL 语句的关系型数据库(如 MySQL, Oracle, PostgreSQL, SQL Server 等)。它是 Java 领域最直接、最底层、最根本的数据库操作方式。

// 1. 建立连接(假设驱动已自动注册)

Connection conn = DriverManager.getConnection("jdbc:mysql://localhost:3306/mydb", "user", "password");

// 2. 直接编写并执行 SQL 语句

Statement stmt = conn.createStatement();

String sql = "INSERT INTO users (name, email) VALUES ('John Doe', 'john@example.com')";

int rowsAffected = stmt.executeUpdate(sql); // 直接返回影响的行数

System.out.println(rowsAffected + " row(s) inserted.");

// 3. 关闭资源

stmt.close();

conn.close();1.9.6 并发

1.9.7 java高级特性和类库

1.9.8 java网络与服务器编程

1.9.9 Java字符串判空

| 方法 | 来源 | null | "" (空串) |

" " (空格串) |

\t\n |

说明 |

|---|---|---|---|---|---|---|

String.isEmpty() |

JDK java.lang.String |

NullPointerException |

T | F | F | 完全等同于string.length()==0 |

StringUtils.isBlank() |

org.apache.commons.lang3.StringUtils |

T | T | T | T | 判定 null/空/空白 都视为“空” |

Strings.isNullOrEmpty() |

Guava com.google.common.base.Strings |

T | T | F | F | isNullOrEmpty 只判 null 或 "",不把空白当空 |

StringUtils.hasText() |

Spring Framework StringUtils |

F | F | F | F | 判定是否至少含一个非空白字符 |

StringUtils.hasLength() |

Spring Framework StringUtils |

F | F | T | T | 只判 str != null && str.length() > 0 |

StringUtils.isNullOrEmpty() |

Spring Framework StringUtils |

T | T | F | F | |

StringUtils.isNullOrEmpty() |

com.mysql.cj.util.StringUtils |

T | T | F | F | 首选,String.isEmpty()基础上加入null判断 |

StringUtils.isEmptyOrWhitespaceOnly() |

com.mysql.cj.util.StringUtils |

T | T | T | T | |

StringUtils.isEmptyOrWhitespaceOnly() |

org.apache.commons.lang3.StringUtils |

T | T | T | T |

1.9.10 Java流操作

map里期待一个函数,将list所有的元素执行一次这个函数重新存放到流中,后续可以用anyMatch进行匹配

List<Integer> numbers = Arrays.asList(1, 2, 3);

// 过滤出大于 1 的数字,然后乘以 10,最后收集成新的 List

List<Integer> result = numbers.stream()

.filter(n -> n > 1) // 只保留 2、3

.map(n -> n * 10) // 变成 20、30

.collect(Collectors.toList());1.9.11 Java传参

java调用某个方法时,如果传递的参数是对象类型,是可以改变外部传入对象的值的,包括对象类型的list。

1.9.12 Java静态函数

静态函数无需创建类实例就能用类名直接调用,但是不可以访问类下的其他变量,包括静态变量

1.9.13 log代码运行时间

获取System.currentTimeMillis()时间,通过log方式读取

1.10 文件传递方法

1.10.1 Base64 编码

什么是 Base64?

Base64 是一种将二进制数据转换为 ASCII 字符串格式的编码方式。它通过将每 3 个字节的二进制数据转换为 4 个 ASCII 字符,便于在文本格式中传输。

适用场景

- 嵌入到 HTML/CSS 中:

- Base64 编码非常适合将小图像(如图标)直接嵌入 HTML 或 CSS 中。这可以减少 HTTP 请求的数量,从而提高页面加载速度。

- JSON/XML 数据传输:

- 在使用 JSON 或 XML 进行数据传输时,Base64 编码可以方便地将图像数据嵌入到文本数据中,避免了对二进制数据处理的复杂性。

- 跨平台兼容性:

- Base64 是文本格式,能够在不同的系统和编程语言间顺利传输,避免了二进制数据在某些情况下的兼容性问题。

优缺点

- 优点:

- 简化数据传输,避免二进制处理复杂性。

- 便于直接嵌入网页,减少 HTTP 请求。

- 缺点:

- 数据量增加约 33%,影响性能。

- 不适合处理大文件。

1.10.2 字节流

什么是字节流?

字节流是一种以二进制格式直接传输数据的方式,适用于文件的上传和下载。

适用场景

- 文件上传与下载:

- 对于大图像文件,使用字节流可以更高效地进行传输,避免了 Base64 编码带来的额外开销。

- 存储和处理大文件:

- 在数据库或文件系统中存储图像时,字节流提供更高的性能,节省带宽和存储空间。

- 支持多种文件类型:

- 除了图像,字节流也能处理多种类型的二进制文件,使其更具灵活性。

优缺点

- 优点:

- 高效处理大文件,避免性能损失。

- 适合多种二进制文件类型。

- 缺点:

- 需要处理二进制数据的复杂性。

- 不适合嵌入文本数据中。

1.10.3 URL 静态资源映射

将图像上传到服务器后,通过 URL 引用图像。这种方式可以大幅减小网页负担,提高加载速度,适合大多数场景。

1.10.4 MinIO

MinIO本质是一种对象存储

1.10.4.1 实战

1.10.4.1.1 Docker拉取

docker run -d -p 9000:9000 -p 9090:9090 \

--name minio \

-e "MINIO_ROOT_USER=admin" \

-e "MINIO_ROOT_PASSWORD=admin123" \

-v /data/minio/data:/data \

-v /data/minio/config:/root/.minio \

quay.io/minio/minio server /data --console-address ":9090"1.10.4.1.2 配置文件

# MinIO 配置

minio:

# minio配置的地址,端口9000

endpoint: http://IP:9000/

# 账号

accessKey: minio-test-user

# 密码

secretKey: test123456

# 按业务模块给不同模块分配桶名

bucketName:

fluency: local-test-bucket

caseSystem: local-test-bucket

animationOpinionControlSystem: local-test-animation-opinion-control-bucket

freeTestSystem: local-test-free-test-bucket1.10.4.1.3 Config

package com.xxx.FileServiceCenter.minIO;

import lombok.Data;

import org.springframework.beans.factory.annotation.Value;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

@Configuration

@Data

public class MinIoConfig {

@Value("${minio.endpoint}")

private String endpoint;

@Value("${minio.accessKey}")

private String accessKey;

@Value("${minio.secretKey}")

private String secretKey;

@Bean

public MinIoUtils creatMinioClient() {

return new MinIoUtils(endpoint, accessKey, secretKey);

}

}1.10.4.1.4 Utils

package com.xxx.FileServiceCenter.minIO;

import io.minio.*;

import io.minio.http.Method;

import io.minio.messages.Bucket;

import io.minio.messages.DeleteObject;

import io.minio.messages.Item;

import lombok.SneakyThrows;

import lombok.extern.slf4j.Slf4j;

import org.springframework.stereotype.Component;

import org.springframework.util.FastByteArrayOutputStream;

import org.springframework.web.multipart.MultipartFile;

import javax.servlet.ServletOutputStream;

import javax.servlet.http.HttpServletResponse;

import java.io.ByteArrayInputStream;

import java.io.InputStream;

import java.io.UnsupportedEncodingException;

import java.net.URLDecoder;

import java.util.ArrayList;

import java.util.LinkedList;

import java.util.List;

import java.util.Optional;

@Slf4j

@Component

public class MinIoUtils {

private static MinioClient minioClient;

private static String endpoint;

private static String accessKey;

private static String secretKey;

private static final String SEPARATOR = "/";

public MinIoUtils() {

}

public MinIoUtils(String endpoint, String accessKey, String secretKey) {

MinIoUtils.endpoint = endpoint;

MinIoUtils.accessKey = accessKey;

MinIoUtils.secretKey = secretKey;

createMinioClient();

}

/**

* 创建基于Java端的MinioClient

*/

public void createMinioClient() {

try {

if (null == minioClient) {

log.info("开始创建 MinioClient...");

minioClient = MinioClient

.builder()

.endpoint(endpoint)

.credentials(accessKey, secretKey)

.build();

log.info("创建完毕 MinioClient...");

}

} catch (Exception e) {

log.error("MinIO服务器异常:", e);

}

}

/**

* 获取上传文件前缀路径

*

* @return {@link String}

*/

public String getBasisUrl(String bucketName) {

return endpoint + SEPARATOR + bucketName + SEPARATOR;

}

/****************************** Operate Bucket Start ******************************/

/**

* 启动SpringBoot容器的时候初始化Bucket

* 如果没有Bucket则创建

*/

@SneakyThrows(Exception.class)

private void createBucket(String bucketName) {

if (!bucketExists(bucketName)) {

minioClient.makeBucket(MakeBucketArgs.builder().bucket(bucketName).build());

}

}

/**

* 判断Bucket是否存在,true:存在,false:不存在

*

* @return

*/

@SneakyThrows(Exception.class)

public boolean bucketExists(String bucketName) {

return minioClient.bucketExists(BucketExistsArgs.builder().bucket(bucketName).build());

}

/**

* 获得Bucket的策略

*

* @param bucketName

* @return

*/

@SneakyThrows(Exception.class)

public String getBucketPolicy(String bucketName) {

return minioClient.getBucketPolicy(GetBucketPolicyArgs.builder().bucket(bucketName).build());

}

/**